AIとは人工知能(Artificial Intelligence)ですが、そもそもよく分かっていません。特に知りたいことはビジネスに対するインパクトの大きさです。一過性の盛り上がりなのか、“クラウド”のように主流としてITビジネスをリードしていくような革新なのかということです。

購入したニュートン別冊は、2018年5月発行なので少々古いのですが、図表も多く内容的にも興味深いものでした。

生成AI(Generative AI)については、NRI(野村総合研究所)さまのサイトをご紹介させて頂きます。“生成AIとは” 3分40秒の動画もあり、大変勉強になります。

こちらのDOORSの寄稿は非常に具体的です。(執筆者はブレインパッドの高田洋平様です)

ブログで取り上げたのは目次の黒字の個所です。

目次

1 基礎から学ぶ人工知能

●人工知能の分類

●人工知能の歴史

●ヒトとコンピューターの画像認識①~②

●ヒトの視覚野のしくみ①~②

●ディープラーニング

●機械学習①~②

●ディープラーニングの未来①~②

2 人工知能の最新応用技術

●人工知能の進化

●将棋プログラム

●アルファ碁

●保健医療分野におけるAIの活用

●人工知能の病理診断

●人工知能の内視鏡検査

●人工知能の眼底検査

●自動運転 ※ばっちゃまの米国株

●人工知能のひび割れ点検

●人工知能の惑星探査

3 人工知能の未来

●人工知能とセキュリティ

●人工知能と公平性

●人工知能とプライバシー

●汎用人工知能①~②

●シンギュラリティ

4 人工知能の新領域へ

●インタビュー 山川 宏博士

人間と調和できる人工知能をつくりたい

●インタビュー 金井良太博士

AIに意識をもたせることで意識の本質にせまりたい

●インタビュー 山本一成氏

AIが将棋の可能性を広げてくれた

●インタビュー 坊農真弓博士

「ロボットは井戸端会議に入れるか」会話にあるルールを解き明かしたい

●インタビュー 井上智洋博士

AIが人間を仕事から「解放」してくれる

●インタビュー 佐藤 健博士

AIに裁判の結果の理由を説明させる

●インタビュー 平野 晋博士

AIに常識や倫理観、感情は必要か

1 基礎から学ぶ人工知能

●ヒトとコンピューターの画像認識①~②

私たちは、どのように画像を認識している?

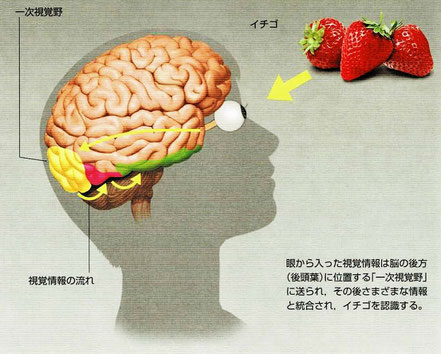

・自動運転や医療診断に欠かせないのは画像認識です。この画像認識を可能にし、人工知能の飛躍的進化をもたらしたのが「ディープラーニング」です。例えば、イチゴを見た瞬間にすぐにイチゴだと分かるのは、眼から入った視覚情報が脳の後方(後頭葉)にある「一次視覚野」に送られ、さまざまな情報と統合されてイチゴと認識されるからです。

コンピューターはディープラーニングで特徴を抽出

・従来のコンピューターは、足し算や掛け算などの計算を大量に行うことはできますが、瞬時にイチゴをイチゴであると認識することはできません。

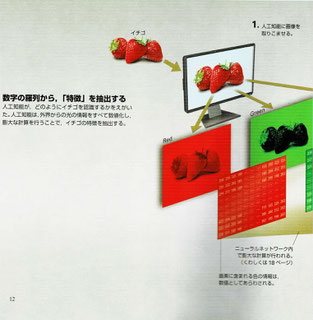

・ディープラーニングはイチゴの画像をすべて数値化し膨大な計算を行うことで、イチゴの特徴を抽出します。

まず、イチゴの画像を非常に細かい画素(ピクセル)に分け、その画素が画像のどこに位置するのかといった「位置情報」と、その画像は何色なのかといった「色情報」を持った数値として処理します。イチゴの画像もコンピューター内では、ただの数学の羅列というわけです。

・イチゴの特徴には、「表面につぶつぶがある」「丸みをおびた三角の形をしている」といった特徴があります。これらの特徴を抽出する必要があるのですが、従来の人工知能ではこの「特徴の抽出」を行うことは難しく、研究者が人工知能に「イチゴとは赤いもの」「イチゴには緑色のへたがついている」など逐一、ルールを教える必要がありました。しかしながら、イチゴの特徴を完全に言語化することは不可能であり、精度よく認識できる人工知能を開発することはできませんでした。

・ディープラーニングでは、脳の構造を模した「ニューラルネットワーク」という方法を用いて、特徴を自動で取り出すルールを自ら獲得することができます。つまり、「特徴の抽出」を行うことができるのです。

●ディープラーニング

コンピューターの中に神経網をつくりだす「ディープラーニング」

・ニューラルネットワークとは神経回路を模してつくられたシステムです。

・ニューラルネットワークは、データを受け取る「入力層」、学習内容に応じてネットワークのつながり方を変える「隠れ層」、そして最終データを出す「出力層」に分けられます。それぞれの層は、「ノード」とよばれる仮想的な領域からなります。ノードでは以下のような計算が行われ、流れる情報の量が制御されます。

これは、人間におけるニューロンのはたらきに相当します。このニューラルネットワークを何層にも重ねる(深くする)ことで作られるシステムが「ディープラーニング」です。ディープラーニングは脳の視覚野と同じように、入力層に近い部分では単純な形しか判別できません。しかし層を重ねることで、より複雑な特徴を得ることができます。そして最終的にコンピューターは、イチゴそのものの概念を手に入れることができるようになります。このようにディープラーニングは、視覚野が行う情報処理のしくみに非常に似ています。

●機械学習①~②

人工知能の“学習”とは、出力結果と正解との誤差小さくすること

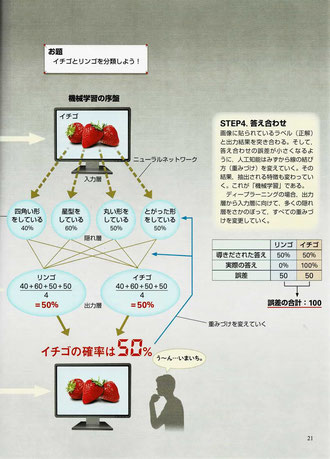

・人工知能は、最初は画像からイチゴの特徴を正しく抽出することも、正しい重みづけをすることもできないので、人工知能はイチゴとリンゴを判別することはできません。そこで、分類した結果の答え合わせを行い、正解との誤差を小さくできるように、重みづけを変えていきます。

コンピューターが“学習”するしくみを見てみよう

・「機械学習」とは、人工知能に試行錯誤を繰り返させ、正しい結果が出せるようにノードとノードの重みづけ徐々に変化させていくことを指します。

・イチゴとリンゴを分類する方法を見てみます。

-学習前の人工知能は重みづけがないので、イチゴがもつ特徴が何か(画像のどこに注目するか)も分かっていません。

[STEP1.画像入力]:イチゴの画像を入力する。この画像には「イチゴ」のレベルが貼られている。

[STEP2.分類]:初期段階では、リンゴとイチゴを分類する特徴が抽出できず、適切な重みづけも不明である。人工知能はすべてを足し合わせ平均をとる。

-人工知能が間違ってリンゴと判定したとしましょう。

[STEP3.結果の出力]:リンゴである確率とイチゴである確率を比較し結果を出す。今回の場合は50%なので判別できない。

-正しい答え(イチゴ)を導き出せるように調整を加えていきます。

[STEP4.答え合わせ]:画像に貼られているラベル(「イチゴ」)と出力結果を突き合わせる。そして、答え合わせの誤差が小さくなるように、人工知能は自ら線の重みづけを変えていく。その結果、抽出される特徴も変わっていく。これが「機械学習」である。ディープラーニングの場合、出力層から入力層に向けて、多くの隠れ層をさかのぼってすべての重みづけを変更していく。

インターネットの拡大が人工知能を賢くした

・人工知能は、何百枚、何千枚と学習を繰り返すことで、徐々に正しい答えを導き出せるようになります。

[STEP5.多くの画像を入力]:人工知能に機械学習を行わせるために、リンゴとイチゴの画像を数多く入力する。このときも、リンゴの画像には人間によって「リンゴ」、イチゴの画像には「イチゴ」と正解ラベルが貼られている。

[STEP6.学習によって適切な特徴と重みづけを得る]:数多くの画像について一つずつ、分類しては答え合わせを行うことで、誤差を小さくしていく。今回の場合、当初の誤差の合計は100だったのに対し、機械学習を繰り返すことで、誤差の合計が30になっていることが分かる。このような計算によって、人工知能は適切にリンゴとイチゴを分類することができるようになる。

・長年、ディープラーニングは実用に耐えるほどの精度が出せないという問題を抱えていました。その理由は、層が深くなるにつれて、答え合わせの結果がうまく隠れ層に伝わらず、重みづけを最適化できなかったためです。

しかし近年、答え合わせの方法を改良したり、本格的な機械学習を行う前に、人工知能を“プレトレーニング”したりすることで、非常に効率よく学習を行うことができるようになりました。

また、インターネットの拡大とともに、使用できる画像データが爆発的に増えたことで、容易に機械学習を行うことができるようになったり、人工知能が行う計算に特化したプロセッサ(中央処理装置)の開発が進んだりしたことも、現在、人工知能の性能が劇的に向上している大きな要因です。

●ディープラーニングの未来①~②

ディープラーニングの活用例

・声の正体は「音波」であり、周波数という数値で表すことができます。この周波数を人工知能に取り込ませることで、「音声認識」が可能になります。iPhoneのSiriなどが該当します。

・日本語や英語の単語は「文字コード」として数値に置き換えられ、翻訳のような「自然言語処理」に利用されています。2016年、Google社はウェブ上で利用できるGoogle翻訳にディープラーニングを用いることで、翻訳の精度を劇的に向上させました。

・囲碁ソフト「AlphaGo」もディープラーニングを用いています。AlphaGoはそのメカニズムは過去のプロ棋士同士の対局中に現れた膨大な石の配置パターンを読み込むことで、その場面における自分が有利か不利かを判断しています。

AlphaGoを開発したイギリスのDeepMind社は更に2017年10月、囲碁ルールのみを与えた「AlphaGo Zero」が40日という短期間で、従来のAlphaGoのどのバージョンよりも強くなったことを発表しました。AlphaGo Zeroで用いられた手法は「強化学習」というものです。強化学習では、研究者は人工知能に過去の対局記録や正しい手筋を教えません。そのかわりに、人工知能同士で対局を行わせ、より多く勝てる打ち筋に「報酬」を与えます。人工知能が自ら、より多くの報酬を得られる、つまりより多く勝てるように試行錯誤して最適な打ち筋を学習していくのです。過去データを用いることなく強くなったことを示すこの結果は、もはや人工知能が人類の手をはなれて進化し続けることを示唆しているといえるかもしれません。

未来を見通すことも可能になりつつある人工知能

・これまでのディープラーニングは主に、静止画像のような「静的な(時間の流れをともなわない)」情報に対して用いられてきました。しかし、動画のように先の展開を予測する必要がある情報の場合、従来のディープラーニングを用いることはできません。

そこで最近、注目を集めている技術が「リカレント・ニューラルネットワーク(RNN)」です。「リカレント」とは「循環する」という意味で、今の時刻の情報を処理する際に、少し前の時刻の情報と統合したうえで処理し、出力することを意味します。少し前の自分の状態に学ぶしくみだということもできます。

私たちは、時々刻々と変化する風景をとらえ、物体の動きを予測し、次の行動を決定します。たとえば正面からボールが飛んできた場合、私たちは反射的によけることが可能です。しかし現在の人工知能は、このような当たり前の予測を行うことができません。なぜなら、ボールが動く映像の実体は、静止画を1枚1枚コマ送りしたものにすぎず、それぞれの静止画のつながりを理解することはむずかしいためです。人工知能にとって「時間」を理解することは困難なのです。

私たちの脳内では、ボールの視覚情報が一次視覚野から二次視覚野、そして高次視覚野へと伝えられる一方で、高次視覚野から一次視覚野へと“逆流”する信号もあるといいます。これは、先に伝わった情報と後から来た情報を統合することで、物体の動きを補正し、正確にとらえるためだと考えられています。この“情報の逆流”を人工知能に搭載した技術がRNNであるといえます。

2 人工知能の最新応用技術

●人工知能の進化

人工知能が動作や言葉を理解し、社会に進出していく

・人工知能は新しい能力を獲得するたびに、人工知能が活躍する領域は広がっていくと考えられます。特に、動作に関連する概念は、ロボットが人間社会で実現に行動するためには必須の能力だといえます。

能力1.画像を正確に見分けられる

能力2.複数の感覚データを使って特徴をつかむ

・今後は人工知能も、視覚情報に温度や音などの情報も組み合わせて、抽象的な概念を理解できるようになります。

能力3.動作に関する概念を獲得する

・「ドアを開ける」といった、自分の動作(例えばドアを押す)とそれがもたらす結果(ドアが奥に開く)を組み合わせた概念です。これらの動作の概念がないと、ロボットは行動計画を立てることができません。

能力4.行動に通じた抽象的な概念を獲得する

・例えば、ガラスのコップは硬いといった抽象的な概念(感覚)は、さまざまな材質のコップを実際に触ったり、落として壊したりすることで獲得できます。こういった感覚は、人間とともに暮らして家事や介護を行うロボットには必須です。

能力5.言葉を理解する

・音声認識や自動翻訳などの言語に関する能力はかなり進んでいますが、まだ人間と同じように言葉を理解しているわけではありません。

能力6.知識や常識を獲得する

・言葉が理解できると、人工知能はインターネット上の情報などから知識や常識を獲得することができるようになります。

3 人工知能の未来

●汎用人工知能①~②

汎用人工知能では、脳をまねてモジュールをつなぎ合わせる

・今の人工知能は、ディープラーニングなどのニューラルネットワークを使用した「モジュール」(プログラムの構成単位)をいくつか組み合わせることでできています。現在は、人間が特定の問題に応じてモジュールを組み合わせて人工知能を設計しています。つまり、その問題しか解けない設計になっています。それに対して、全能アーキテクチャが目指す「汎用人工知能」は、私たちの脳が普段から行っているように、必要に応じて複数のモジュールを自動的に組み合わせることを目指しています。臨機応変に自分自身の設計(プログラム)を変えることで、さまざまな問題を柔軟に解決できるようになります。

・現在の開発状況から見て、人間と同程度の能力をもつ汎用人工知能は2030年頃に完成するのではないかという声が出ています。

大脳基底核や大脳皮質のほか、運動に関わる小脳に相当する人工知能の開発は比較的進んでいますが、海馬に相当するものや、それらを統合するための人工知能の開発は遅れています。

未知の状況に対応する能力をもつ汎用人工知能は、自律的な行動が求められる「災害救助ロボット」や「惑星探査機」などに応用されることが期待されています。

・モジュールは、脳の各部位や領野に対応するプログラムです。全脳アーキテクチャでは、各モジュールを必要に応じてさらに細かい機能に分類して、それらを統合することで、人間の脳と同じような機能を実現する汎用人工知能を目指しています。

●シンギュラリティ

シンギュラリティの到来時期は賛否両論

・「シンギュラリティ(singularity)」は技術的特異点と訳される。人工知能が自分自身で猛烈な進化を続けると、人間の知能を追い抜き、遂には人類がその先の変化を見通せない段階まで進化するという説があります。これはアメリカの人工知能研究者であるレイ・カーツワイル博士が2005年に発表した著書『シンギュラリティは近い』によって世界に知られるようになりました。

・あと数十年でシンギュラリティがやってくるという説には否定的な意見は少なくありません。しかしながら、時期は分かりませんが人工知能がこのまま進化することで、あらゆる分野で人間の知能を上回る時代がいずれやってくることについては、人工知能研究者の多くが同意しているようです。

4 人工知能の新領域へ

●インタビュー 平野 晋博士

AIに常識や倫理観、感情は必要か

『AIネットワーク社会推進会議で取りまとめられた「国際的な議論のためのAI開発ガイドライン案」。AIの著しい発展を受け、近い将来、社会にAIネットワークが構築されることを前提として検討された九つの開発原則である。ただし、このガイドライン案はあくまで指針案であり、法的な拘束力はない。』

感想

『人工知能は新しい能力を獲得するたびに、人工知能が活躍する領域は広がっていくと考えられます』これが全てのように思います。

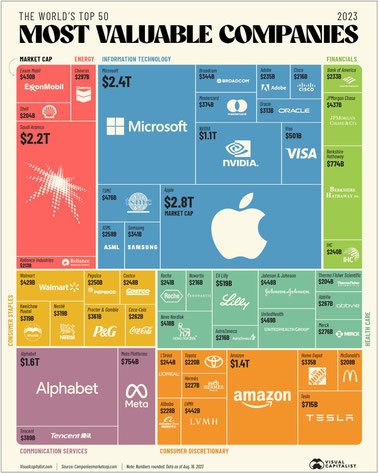

過熱状態は落ち着き、浮き沈みはあるでしょうが、生成AIはクラウドに匹敵するようなITを長期的に牽引する革新になるだろう思います。

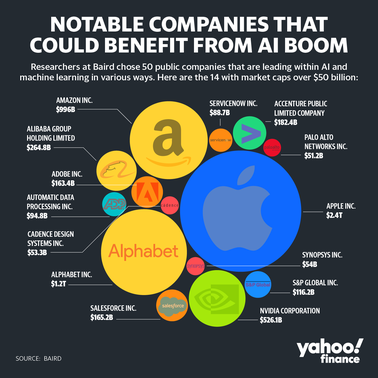

開発環境あるいは開発支援のサービスも充実してきています。AIをリードしているNVIDIAといえばGPUという汎用型のAIアクセラレーターで有名ですが、各ニーズに対応した特化型のAIアクセラレーターも登場しています。CPUの両雄(IntelとAMD)も動いているようです。特にAMDは2023年6月にMI300Xという汎用型GPU(GPGPU)を発表しました。Big TechのMetaも、Google、Amazonに続きAI用の独自チップの開発を発表しました。さらに、テスラは独自に設計したチップとインフラストラクチャを使用したカスタムスーパーコンピューター“Dojo”を発表しました。

ソフトウェア、ハードウェアの進歩は止まることはありません。世界中の研究者によって新しい技術が“今”を変えていきます。そして、人工知能のニーズは医療、介護、小売、運輸、災害支援、宇宙開発など多岐に渡ります。

仮想空間はアバターを利用してネット上で交流する“メタバース”に進化しました。通信では5Gに続く、“Beyond5G(6G)”は2030年頃と目されているようです。

シンギュラリティが本当にやってくるのか、それはいつか、不安もありますが、おそらく人類の進歩の歴史の中で、それは避けられないのではないかと思いました。

画像出展:「Yahooニュース」

米議会は9月13日、テスラのイーロン・マスクCEOのほか、メタ・プラットフォームズのマーク・ザッカーバーグCEO、アルファベットのスンダー・ピチャイCEOらテクノロジー業界の幹部を招き、人工知能(AI)に関するフォーラムを開催した。写真は、米議会で開かれたAIフォーラム(2023年 ロイター/Leah Millis)

『上院民主党トップのシューマー院内総務はフォーラムの冒頭「超党派のAI政策の基盤を整備するという巨大で複雑、かつ重要な取り組みをきょう開始する」と表明。「議会が役割を果たさなければ、AIの恩恵を最大化することも、AIのリスクを最小化することもできない」と述べた。

また、とりわけディープフェイクについては優先的に対応し、2024年の選挙前に規制する必要性があると強調した。

フォーラムは非公開で開催。60人を超える上院議員のほか、エヌビディアのジェンスン・ファンCEO、マイクロソフトのサティア・ナデラCEO、IBMのアービンド・クリシュナCEO、マイクロソフト創業者のビル・ゲイツ氏らも参加した。』

ご参考:“テスラが開発中のロボット(Optimus)の動画”