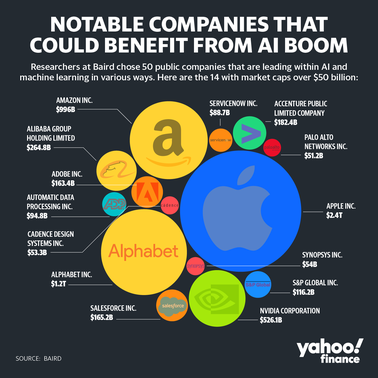

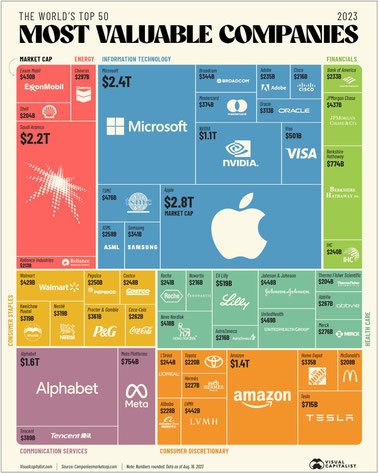

GPUを支える技術3

第6章 GPUの周辺技術

6.2 CPUとGPU間のデータ転送

・高性能のGPUでゲームをプレイする場合などは描画のために大量のデータをGPUに送り込む必要があるため、CPUとGPUの間のデータ転送速度が非常に重要である。

●NVIDIAのNVLink

・NVIDIAが開発した伝送チャネルで、伝送速度は20Gbit/sでPCI Express3.0の2.5倍の速度である。

●NVIDIA NVSwitch

・NVIDIAが2018年に開発した18ポートのクロスバースイッチで、16台のV100 GPUを相互接続できる。これにより16個のV100 GPUのデバイスメモリが連続した512GBの大きなメモリ空間になるため、どのアドレスでもアクセスしてRead/Writeできる。これによりGPU間でデータコピーする必要がなく処理の分散が容易になる。

第7章 GPU活用の最前線

7.1 ディープラーニングとGPU

・ディープラーニングの計算処理の大部分はGPUが得意な行列の積の計算である。

・NVIDIAは自動運転用のGPUを内蔵したSoCを製品化している。

・自動運転、車の自動化にはAI用のGPUが搭載される可能性がある。

・画像認識はロボットや自動運転車の眼として重要な技術で、従来は画像認識の専門家がシステムを作っていたが、2012年にディープラーニングを使ったシステムが従来のシステムを大幅に上回る成績を達成したことから、画像認識の研究はディープラーニング中心になった。

・認識精度の向上につれて、ニューラルネットワークの規模も拡大されてきている。2020年のOpenAIの自然言語処理システムGPT-3では175B(175兆個)パラメータという巨大モデルが出現している。(GTP-4のリリースは2023年7月、GTP-4 Turboは2023年11月)

●ディープラーニングで使われるニューラルネットワーク

ネットには多くのサイトや動画がありましたが、特にいいなと思ったサイトをご紹介させて頂きます。

『本記事では、膨大なデータを分析・解析を行うためにAIの導入を検討している人向けに、ニューラルネットワークの仕組みや関連用語などを中心に解説します。また、活用事例も紹介するので、今後のAI導入の参考にしてください。』

”ニューラルネットワークとは?仕組みや歴史からAIとの関連性も解説”

『この記事では、ニューラルネットワークの基礎知識から代表的な種類、変遷の歴史まで解説します。AI技術やディープラーニングとの関係についてもわかりやすく説明しますので、AIサービスの研究や開発を検討する際にぜひ参考にしてください。』

”AIビジネスを考える上で押さえておきたい、ニューラルネットワークの実用例30選”

『人工知能分野のニューラルネットワークは、人間の神経回路の仕組みをまねる、機械学習の一手法です。 さまざまな分野でのビジネス利用が活発になり、大きな成果をあげる実例も出ています。』

”大規模言語モデル(LLM)とは? 仕組みや種類・用途など”

『近年ではさまざまな生成AIが登場していますが、そのなかでも注目を集めているものが「大規模言語モデル(LLM)」を活用したものです。以前からコンピューターと対話する形のAIは存在していましたが、大規模言語モデルの登場により、その精度は格段に向上しました。従来の言語モデルと比べて大規模言語モデルはどのような特徴を持つのでしょうか。』

●ディープラーニングで必要な計算とGPU

・推論やディープラーニングの学習も大量の行列と行列の積の計算が必要なので、GPUであればCPUよりはるかに高い処理性能が期待できる。

・ディープラーニングの推論は、16ビットの半精度浮動小数点、あるいは値を適切に量子化すれば、8ビットの固定小数点で計算してもほとんど推論結果には影響がない。

●ディープラーニングでのGPUの活用例

・画像認識は多くの分野で利用が始まっている

-ドローンの眼として画像認識の必要性が高まっており、低電力のGPUのシステムが開発されている。

-セキュリティ用の監視カメラに対し、状況の危険度の判定や通報、不審者の顔認識をすることで大幅に機能を高めることができる。

-医療画像の読影はディープラーニングにより、細かい病変の発見に貢献できる。ただし、医療機器としての活用には大量の事例による有効性の検証が必須である。

・NVIDIAは自動運転に向けたSoCに注力

-自動運転には画像認識が重要であるが、大量の計算が必要である。

-NVIDIAは自動運転を次世代のビジネスの柱として、2019年にDrive AGXOrinを発表した。

-NVIDIAは2000TOPS(Tera Operations Per Second)のコンピュータではレベル5のロボタクシーの実用化を目指している。

-NVIDIAは、AIスパコンを自社に設置し、いろいろな天候や周囲の明るさのシナリオを生成したり、実際には存在していない色々な障害物(子供の飛び出しや、前の車の落とし物など)をシナリオに加えたりして、自動運転システムを学習させてAIの品質改善を続けている。

7.2 3DグラフィックスとGPU

●VR、ARの産業利用

・VRはVirtual Reality、ARはAugmented Realityである。

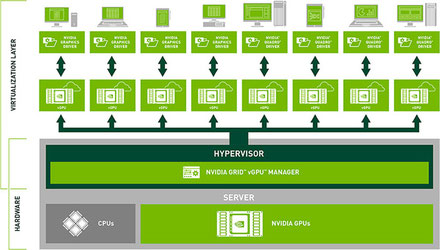

●NVIDIAのGRID

・NVIDIAは中央のサーバと仮想化された端末で、各端末のGPUを搭載することなく快適なグラフィックススピードを提供できるNVIDIA GRIDというシステムを提供している。

”仮想デスクトップのグラフィックス処理を高速化「NVIDIA GRID」”

こちらの記事はアセンテック(株)さまからです。

図はNVIDIA GRIDのシステム構成図です。

また、同ページにに”動画:NVIDIA GRID CPU と vGPU の対照比較 ”がありました。(1分19秒)

タイトルは「NVIDIA GRID vGPU vs. CPU Only - Siemens NX Horizon View with VMware Horizon & vSphere」です。

●物理的に複数ユーザーにGPUを分割するMIG

・MIG(Multi Instance GPU)はAmpere A100に付加された機能で、7個のGPUを個別のユーザーに割り当てるもので、他のユーザーの影響をほとんど受けない独立性の高い分割使用環境を実現する。

7.4 スーパーコンピュータとGPU

●世界の上位15位までのスーパーコンピュータの状況

・スーパーコンピュータの世界には、TOP500という性能ランキングがある。

・GPUの課題はプログラミングが難しいことがある。

『TOP500 プロジェクトは、7 年間使用されていたマンハイム スーパーコンピュータの統計を改善および更新するために 1993 年に開始されました。

当社のシンプルな TOP500 アプローチでは、「スーパーコンピューター」そのものを定義しませんが、ベンチマークを使用してシステムをランク付けし、TOP500 リストに入る資格があるかどうかを決定します。 』

こちらの記事は「ITmedia」さまより拝借しました。

『同社が独自に開発したデータセンター規模のスーパーコンピュータ「Eos」をブログと動画で披露しました。 』

写真をクリック頂くと、動画“Eos: The Supercomputer Powering NVIDIA AI's Breakthroughs”がご覧頂けます。(2分8秒)

第8章 ディープラーニングの台頭とGPUの進化

8.2 各社のAIアクセラレータ

●GoogleのTPU

・Googleはデータセンターの負荷が2倍になった場合、それをCPUの増設で対応するのは高コストのため、ディープラーニングの計算を効率的に行うことができるハードウェアの開発に着手した。

・Googleは学習時間を短縮するため、多数のTPU(Tensor[線形的な量または線形的な幾何概念を一般化したもの] Processing Unit)をネットワークで接続したマルチTPUのディープラーニング用のスーパーコンピュータを作ることになった。

画像出展:「GPUを支える技術」

右端が演算回路部分で、重みを供給する重みFIFO(First In First Out) 、行列積を計算するマトリクス乗算ユニットMXU(Matrix Multiply Unit)がある。

●NVIDIAのTensorコア

・計算回数に比べメモリアクセス回数が少なく、メモリアクセスがボトルネックにならず演算性能を出しやすい。

『NVIDIA A100 Tensor コア GPU は、あらゆる規模で前例のない高速化を実現し、AI、データ分析、および HPC 向けの世界で最も性能能力の高いエラスティック データ センターを強化します。』

●Habana LabsのGoyaとGaudi

・Habana LabsはイスラエルのAIチップメーカーだが、2019年12月にIntelに買収された。

・Goyaはデータセンター向けの推論アクセラレータ、Gaudiはデータセンター向けの学習アクセラレータである。

8.3 ディープラーニング/マシンラーニングのベンチマーク

●MLPerfベンチマーク

・MLPerfはディープラーニングの実行性能を測るベンチマークである。

『学界、研究機関、業界の AI リーダーたちによるコンソーシアムである MLCommons によって開発された MLPerf™ ベンチマークは、ハードウェア、ソフトウェア、サービスの学習と推論の性能を公平な評価を提供するように設計されています。』

“NVIDIA、MLPerf ベンチマークで生成 AI トレーニングを飛躍的に加速”

『10,752 基の NVIDIA H100 Tensor コア GPU と NVIDIA Quantum-2 InfiniBand ネットワーキングを搭載した AI スーパーコンピューターである NVIDIA Eos は、1,750 億のパラメーターを持つ GPT-3 モデルを10 億のトークンでトレーニングするベンチマークを、わずか 3.9 分で完了しました。』

8.4 エクサスパコンとNVIDIA、Intel、AMDの新世代GPU

●NVIDIAのAmpere A100 GPU

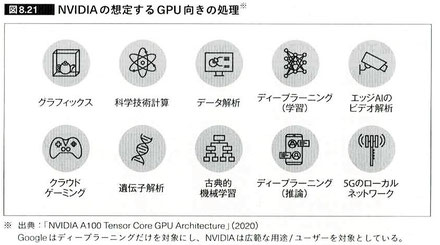

・GoogleのTPUはディープラーニングの学習と推論計算を効率よく実行する専用チップだが、NVIDIAのA100 GPUはグラフィックスや科学技術計算、データ解析、クラウドゲーミング、遺伝子解析などさまざまな用途のアクセラレータとして使えるように設計されている。

●Intelは新アーキテクチャのXe GPUを投入

・グラフィックスの世界はNVIDIAとAMDの独占状態だったが、グラフィックスだけでなく科学技術計算やディープラーニングの分野でも広く使われるようになってきて、Intelの牙城であるデータセンターをNVIDIAやAMDのGPUが侵食してきている。

●AMDは新アーキテクチャCDNA GPU開発へ

・AMDは2020年11月に大規模科学技術計算やディープラーニング計算をターゲットとするCDNAアーキテクチャを発表し、Instinct MI100 GPUを発表した。

8.5 今後のLSI、CPUはどうなっていくのか?

●微細化と高性能化

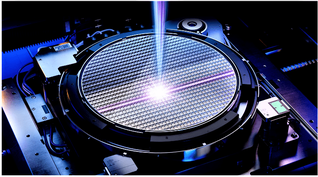

・現状で微細なパターン描画の最大の障害は光の波長である。

・EUV波長で乱れのない凹面反射鏡のレンズは特殊技術が必要で、ドイツのZEISS(ツァイス)は作ることができる。そして、このレンズを使うEUVの露光機を作れる会社はオランダのASMLである。

・微細化はスローダウンしながらも進歩している。しかし、厚みは薄くても高い電圧に耐える絶縁膜材料を探すというアプローチは原理的には可能だが、加工法などを含めて代替になる新材料の開発には長い時間が掛かるため、険しい道と考えられている。

『EUV露光は、7nm以降の微細回路パターンをシリコンウェーハ上に転写(露光)するための技術として、2019年に台湾のTSMCによって初めて量産投入された技術である。』

●チップレットと3次元実装

・業界で期待されているのは3次元実装である。なかでも一番実用化が進んでいるのがHBM(High Bandwidth Memory)である。

“「HBM(High Bandwidth Memory)」とは”

“NVIDIA、HBM3eメモリ採用の次世代GH200を発表”

●CPUはどうなっていくのか

・CPUは量的にはスマートフォンなどのSoCに使われるのが大部分である。また、IoTも主要なCPUユーザーになっていくと考えられる。一方、売り上げや利益の面では、クラウドサービスを提供する大規模データセンターがCPUの主要なユーザーである。従って、この2つの分野に向けてCPU開発が行われていくと考えられる。一方、ArmアーキテクチャのCPUをデータセンターに使おうという動きもある。その代表がAmazonのAWS Graviton CPUである。AmazonはArmのNeoverseアーキテクチャのデータセンター用のCPUを自社で開発し、使用している。

・Armアーキテクチャはサーバ市場における普及の入り口に立っているかもしれない。

8.7 まとめ

・重要なことはCPUとGPUは適材適所で仕事を分担することである。微細化はかなり進んできており、微細化だけで約10倍のトランジスタが使えるようになると予想されている。さらに3次元実装を組み合わせれば、さらに10倍以上はいけるので、CPU、GPUには大きな進化の余地は残っている。一方、大きな問題は発熱で、これには消費電力を減らすことが最も重要になる。そのために、半導体技術、回路設計技術、論理設計技術、アーキテクチャの各分野で努力が続けられている。

・GPUメーカーは並列プログラミングとCPU-GPU分離メモリから生じるプログラミングの難しさの軽減にも取り組んでいる。そして、GPUの使用分野の拡大にも力を入れており、ますます私たちの生活の中に入り込んできている。

・『本書では、GPUとはどのようなものなのか、なぜ計算性能がCPUより格段に高いのか、GPUのプログラミングはどのようにするのか、さらにニューラルネットワークの計算はどのように行われるのかなどの基本事項とともに、最新の話題や将来の見通しを含めてGPUについて解説しました。』

感想

第1章に「文字だけでなく図が加わると、情報の伝達が飛躍的に容易になる」ということが書かれており、「これだ!」と思いました。

例えば、営業でプレゼンテーションを行う場合、文字だけでなく図や表、あるいはイラストや動画などを使って効果的に説明します。また、理解する側の立場にたっても、特に目新しいことについては、文字情報だけでは理解が難しいということが多々あります。ブログの冒頭にご紹介した設計システムのCADも、2次元の製図より3次元の立体モデルの方が、デザイン、設計、製造など開発・生産の各工程に関わる人の理解を助けます。

人の気持ちを理解する場合、特に隠れた「気持ち」は微妙に表情に出ることが多く、言葉に加え目からもたらされる視覚情報は、その人の気持ちや考えを深く理解する上で、非常に役に立ちます。これらは“非言語コミュニケーション” と言われています。

上記はNVIDIAの資料で、GPUの主な用途が紹介されています。これらのコンピューティングには文字だけでなく、画像や映像の情報処理が強く求められます。

個人的には、AIはニューラルネットワ-クという新しいコンピュータ言語によるITの革新のように思っていましたが、それに加えて、非言語コミュニケ-ションのコンピュータ化という側面もあるように感じました。

ご参考:【GTC】2024年3月18日-21日

NVIDIAが3月18日から21日までの4日間、カリフォルニア州サンノゼの サンノゼ マッケンナリー コンベンション センターでカンファレンスを行いました。興味があったので登録してみたところ、毎日メールが届き、以下のようなサイトに案内されました。

“GTC March 2024 Keynote with NVIDIA CEO Jensen Huang”

まさに『産業の米、AIの米』だと思いました。クラウドAIからエッジAI、そして、開発支援、トレーニング(学習)など、AIの全てを網羅しているという感じです。

※医療(Healthcare):“Healthcare Reimagined with Artifi” 1分35秒

※ロボット:“NVIDIA Robotics: A Journey From AVs to Humanoids” 3分42秒

※自動運転:”NVIDIA AI Tools for Autonomous Vehicle Developers” 2分23秒

※3D共同開発プラットフォーム:“NVIDIA Omniverse Cloud APIs on Microsoft Azure” 1分36秒

※CEO ジェンスン・フアン:“Jensen Huang, Founder and CEO of NVIDIA” 56分26秒

News(2024年7月26日):“中国「無人タクシー」急増 実際に乗ってみた” (YouTube 5分47秒)

画像出展:「中国で「無人タクシー」が急増 実際に乗ってみた(FNNプライムオンライン)」

なんと、中国では既に無人タクシーの営業が始まっていました。北京、重慶、広州市など全国4カ所で営業スタート。2025年までに中国の全国で無人タクシーを導入したいとのことです。

日本では過疎化する高齢者地域の交通手段として、とても魅力的ではないかと思いました。

GPUを支える技術2

第2章 GPUと計算処理の変遷

2.1 グラフィックとアクセラレータの歴史

・2020年11月時点では、スーパーコンピュータの性能をランキングするTOP500リストの中で、147システム(約30%)がGPUをベースとする計算アクセラレータを使っている。

画像出展:「NVIDIA」

『世界の最高峰のスーパーコンピュータは、これまでより高速になっているだけではありません。よりスマートになっており、多様なワークロードにも対応しています。SC20で発表された、世界最速のスーパーコンピュータ TOP500リストのうちおよそ70%、および上位10システムのうちの8システムでNVIDIAのテクノロジが採用されています。』

“Eos: The Supercomputer Powering NVIDIA AI's Breakthroughs” Youtube 2分7秒

2.3 GPUの科学技術計算への応用

●CUDAプログラミング環境

・GPUの性能を生かすには従来のOpenGLでは限界があった。これに対し、NVIDIAは科学技術計算プログラムを記述するCUDA言語とそのコンパイラやデバッガツールを提供した。

第3章 [基礎知識]GPUと計算処理

3.1 3Dグラフィックスの基本

・3次元(3D)のモデルを表示するプログラム言語はOpenGL(GLはGraphics Languageの意味)とDirectXが標準的に用いられている。前者は業界標準のKhronos Groupが管理している。後者はマイクロソフトがWindowsのゲームなどを買い開発するために作った規格である。

●[基礎知識]OpenGLのレンダリングパイプライン

・レンダリングとはデータを処理もしくは、演算により画像や映像として表示させることである。そして、モデルデータの入力から出力までの加工手順のことを、レンダリングパイプラインという。

ご参考:床井研究室 (和歌山大学の床井浩平先生だと思います)

この床井先生のホームページに知りたいことが書かれていました。それはグラフィック処理におけるソフトウェアとハードウェアの共同作業ということです。

レンダリングパイプライン

形状データから画像を生成する方法は、サンプリングによる方法(レイキャスティング法、レイトレーシング法)とラスタライズによる方法(デプスバッファ法、スキャンライン法など)の二つに大別されます。後者は座標変換により形状データのスクリーンへの投影像を求め、それを走査変換によりスクリーン上で画素に展開(ラスタライズ)して画像を生成します。これはおおよそ以下の手順に整理されており、レンダリングパイプラインと呼ばれています。

画像出展:「床井研究室」

『形状データから画像を生成する方法は、サンプリングによる方法 (レイキャスティング法、レイトレーシング法) とラスタライズによる方法 (デプスバッファ法、スキャンライン法など) の二つに大別されます。後者は座標変換により形状データのスクリーンへの投影像を求め、それを走査変換によりスクリーン上で画素に展開 (ラスタライズ) して画像を生成します。これはおおよそ図の手順に整理されており、レンダリングパイプラインと呼ばれています。』

画像出展:「床井研究室」

『最初、この手順はソフトウェアで実装されていました。しかし、CG というのは何らかの計算結果を画像化することが目的なので、画像化の作業にもCPUを使うことは無駄だと考えられました。そこで最初に、単純な整数計算とメモリアクセスの繰り返しである走査変換が、専用のハードウェアで実現されました。これにより画像生成の速度が劇的に向上したとともに、CPUは画像化の作業から開放され計算に専念できるようになりました。 』

画像出展:「床井研究室」

『モデリング変換や視野変換(この二つはまとめてモデルビュー変換とも呼ばれます)、および投影変換といった座標変換や、陰影計算 (shading) には、実数計算が含まれます。しかし、高速な実数計算ハードウェアはコストが高かったので、当初グラフィックスハードウェアには搭載されていませんでした (32bit CPU でも初期のものには内蔵されていませんでした)。この部分をハードウェアで実装したこと(ハードウェア T&L-Transform and Lighting) によって、リアルタイム3D CG が本格的に利用されるようになってきました。 』

画像出展:「床井研究室」

『レンダリングパイプラインの処理内容はここまであまり変化してこなかったので、ハードウェア化はレンダリングパイプラインの各段階の機能をハードウェアで実現する形で行われました(固定機能ハードウェア)。このため新しい機能が必要になるたびに、それを実現するハードウェアが追加されてきました。しかしCGの応用が広がり多様な表現が要求されるようになってくると、こうして機能を追加することが難しくなってきました。

そこで、機能を追加する可能性がある部分をプログラム可能にして、ソフトウェア的に機能を拡張できるようにすることが考えられました。それまで座標計算と(頂点の)陰影計算を担当していたハードウェアはバーテックスシェーダに置き換えられ、走査変換により選ばれた画像の各画素の色を頂点の陰影の補間値やサンプリングしたテクスチャの値を合成(マージ)して決定していたハードウェアはフラグメントシェーダに置き換えられました。また、フラグメントシェーダから光源情報や材質情報を参照することや、テクスチャをバーテックスシェーダから参照すること (vertex texture fetch) も可能になりました。』

画像出展:「床井研究室」

『さらに、それまでアプリケーションソフトウェア側で行われていた基本形状(点, 線分, 三角形)の生成の一部を、グラフィックスハードウェア側で行うことができるようにもなりました。これにより、アプリケーションソフトウェア(CPU)からグラフィックスハードウェアに送られる形状データの量を減らしながら、より高品質な形状の表現が行えるようになりました。これはジオメトリシェーダにより行われます。なお、ジオメトリシェーダの利用はオプションなので、使用しなくてもかまいません。 』

●フラグメントシェーダ

・OpenGLではフラグメント、DirectXではピクセルと呼ばれている。フラグメントシェーダはフラグメントの色と奥行き方向の位置を計算するシェーダ(陰影処理を行うプログラム)である。

・Zバッファは奥行き方向の座標(Z座標)を記憶する機構である。

・ブレンディングは半透明のための処理のことである。

・テクスチャマッピングはテクスチャを立体の表面に張り付ける手法である。

・ライティングは光の当たり具合、反射、光源である。

・フラグメントシェーディングは各ピクセルの明るさや色を計算すること。平面はフラットシェーディング、面の継ぎ目が目立たないようにしたのがグローシェーディングである。

・レイトレーシングは反射した光の光路を計算し、反射による映り込みを表現する。

3.2 グラフィック処理を行うハードウェアの構造

・OpenGLやDirectXで書かれたプログラムを高速で処理するのは、ハードウェアが必要である。IntelのPC用プロセッサであるCoreiシリーズプロセッサは、CPUチップの中にGPUコアを内蔵している。また、グラフィックスボードは画像処理に特化した計算を行うGPUを搭載している。

こちらは2012年のものなので、内容は古いのですが35年前(1989年)を起点に考えると約20年間の歩みが分かるので、私にとっては貴重な資料でした。(PDF11枚)

『3次元コンピュータグラフィックスをレンダリングするためには非常に多くの演算を必要とする。従来はCPU(Central Processing Unit)上でそれらの計算を行っており、計算コストが非常に高いという問題があった。そのために、産業分野などで3次元レンダリングが必要な場合には SGI(Silicon Graphics Interface)など、3次元演算専用のハードウェアを搭載した高価なワークステーションを用いていた。

一方、1999年8月にNVIDIAからGeForce256という、パーソナルコンピュータ(PC)向けグラフィックスボードが発表された。これは、PC上で1500万ポリゴン/秒及び4億8000万ピクセル/秒の描画速度を実現した。NVIDIAは、このようなグラフィック処理を行うハードウェアを GPU(Graphic Processing Unit)と呼ぶようになった。』

3.3 [速習]ゲームグラフィックとGPU

●PlayStationとセガサターンが呼び込んだ3Dゲームグラフィック・デモクラシー

・今ではNVIDIAとAMD(当時はATI Technologies)の二強時代だが、1990年代後半は数十社のメーカーがPC向けの独自のグラフィックスハードウェア製品をリリースしていた。なかでも一時代を築いたのが3dfx Interactiveで、Voodooシリーズと呼ばれるグラフィックスハードウェア製品は当時のPCゲームファンの間に絶大な人気を博していた。

3.4 科学技術計算、ニューラルネットワークとGPU

●科学技術計算の対象は非常に範囲が広い

・科学技術計算の範囲は非常に広いが、それらに共通していることは解析しようとする現象の物理モデルを作り、そのモデルを使って現象がどのように変化していくかを計算で求めるという点である。

・スーパーコンピュータの「富岳」の課題は9つである(文部科学省の資料より)

1)生体分子システムの機能制御による革新的創薬基盤の構築

2)個別化/予防医療を支援する統合計算生命科学

3)地震/津波による複合災害の統合的予測システムの構築

4)観測ビッグデータを活用した気象と地球環境の予測の高度化

5)エネルギーの高効率な創出、変換/貯蔵、利用の新規基盤技術の開発

6)革新的クリーンエネルギーシステムの実用化

7)次世代の産業を支える新機能デバイス/高性能材料の創成

8)近未来型ものづくりを先導する革新的設計/製造プロセスの開発

9)宇宙の基本法則と進化の解明

●科学技術計算と浮動小数点演算

・お金の計算や在庫の計算などは整数が良いが、科学技術計算では非常に大きい数や非常に小さい数が出てくるため、浮動小数点演算が必要になる。

●ディープラーニングに最適化された低精度浮動小数点数

・ディープラーニングではニューラルネットワークが使われるが、入力信号に重みを掛けさらに全入力の信号の総和をとる方式のため、多少の誤差は問題にならない。そのため、半精度で問題ないと考えられている。現在では、NVIDIA、AMD、Intelが半精度浮動小数点演算をサポートしている。

3.5 並列計算処理

・2005年頃からCPUのクロック(周波数)は消費電力の問題から頭打ちとなり、各メーカーはプロセッサのコア数を増やして性能を上げる方向に舵を切った。

●GPUのデータ並列とスレッド並列

・並列処理にはそのためのプログラムが必要になる。

・1つの命令で複数のデータを処理する方式(SIMD)だが、GPUが使っているのはSIMT(Single Instruction, Multiple Thread)であり、各スレッドが1つの仕事を担当し、複数のスレッドを並列に実行するという方法である。

3.6 GPUの関連ハードウェア

●デバイスメモリに関する基礎知識

・標準的なGPUで4~8GB、ハイエンドのGPUで12~24GB。

●CPUとGPUの接続

・GPUではOSを動かさない。これは割り込みやセキュリティ機能の不足もあるが、1番の問題は並列処理では難しい命令を高速処理することができないためである。このため、科学技術計算の入力データなどはCPUに読んでもらう必要があり、CPUとGPUの共同作業になる。

・NVIDIAが開発したのはNVLinkとNVSwitchである。

第4章 [詳説]GPUの超並列処理

・GPUはグラフィック処理を高速に実行する目的で開発されたが、その後、科学技術計算やAIのディープラーニングなどにも活用されるようになった。

4.2 GPUの構造

・GPUと300Wを消費するハイエンドGPU(NVIDIAとAMDが市場を二分する)と数Wのスマートフォン用SoCのGPUでは作りは異なる。

●NVIDIA Turing GPUの基礎知識

・NVIDIAはユニファイドシェーダ化やCUDAプログラミング言語の開発など、科学技術計算の先頭を走ってきた。さらに、ディープラーニングへのGPUの適用、自動運転車へのGPUの適用という新しい分野でも先頭を走っている。

・TuringアーキテクチャのGPUチップは「TU」が付けられ、番号は「100」が科学技術計算用の高性能チップとなっている。

●NVIDIAのTensorコア

・GoogleがTPUを自社開発し、ディープラーニング演算の性能を高めたのと時を同じくして、NVIDIAはVolta GPUの行列乗算用の演算ユニットであるTensorコアを搭載した。

4.3 AMDとArmのSIMT方式のGPU

●AMD RDNAアーキテクチャGPU

・AMDが2012年に発表したGPUはGCN(Graphics Core Next)というアーキテクチャを使ってきたが、2019年11月にRDNA(Radeon DNA)を発表し、性能/電力を50%改善したとした。

4.4 GPUの使い勝手を改善する最近の技術

●ユニファイドメモリアドレス

・ユニファイドメモリアドレスはCPUのメモリとGPUのメモリに重複しないメモリアドレスを割り当て、アドレスを見ればそれがCPUメモリかGPUかを識別できるというもの。

●NVIDIA Pascal GPUのユニファイドメモリ

・NVIDIAはPascal GPUで、ユニファイドメモリアドレスを一歩進めて、あたかもCPUとGPUが共通にアクセスできるメモリのように動作するユニファイドメモリという機能をサポートした。

4.5 エラーの検出と訂正

・宇宙線に起因する中性子の衝突で電子回路はエラーを起こす。グラフィックでは問題にならないが科学技術計算では計算途中で起こった1回のエラーが最終の計算結果を誤らせるということが起こる。問題はエラーが起こったかどうかが分からないと計算結果を信用できないということである。

●科学技術計算の計算結果とエラー

・エラーが発生していないことを100%保証することはできない。そこでエラーを見逃すことがほとんどないというシステムを作ることが重要になる。

・「エラーが起こっていない」=「エラーが起これば検出できる」という機能が必須である。

第5章 GPUプログラミングの基本

5.1 GPUの互換性の考え方

・CPUは上位互換が一般的だが、GPUはまだ発展途上の技術のためハードウェアの変更が多く、CPUのような上位互換の実現は難しい。

●ハードウェアの互換性、機械語命令レベルの互換性

・CPUの世界ではIntelのCPUとAMDのCPUは命令互換のため、Intel用とかAMD用はない。

・IBMのPOWERやArmのプロセッサ、あるいはRISC-Vの間ではハードウェアの互換性はないため、それぞれに専用のバイナリ(機械命令)プログラムを使う必要がある。

・スマートフォンなどで使われているAndroidは仮想マシンの技術を使って、異なるアーキテクチャのプロセッサを仮想的に同じハードウェアに見せることで互換性を実現している。

●GPU言語レベルの互換性

・CUDAやOpenCLという言語は多くの場合、C言語で開発されている。CUDAはNVIDIA独自の言語だが、OpenCLは業界標準のプロセッサ言語である。

5.2 CUDA[NVIDIAのGPUプログラミング環境]

・CUDAはGPUのプログラミングに必要な最低限の機能を、C言語に追加するというアプローチで開発された。

●NVIDIA GPUのコンピュート能力

・NVIDIAはそれぞれのGPUについてコンピュート能力という値を公表している。コンピュート能力はSM(Streaming Multiprocessor)の機能を公表している。

5.5 OpenMPとOpenACC

・C言語などで書かれたソースコードに、この部分はGPUを使って並列実行といった指示を書き加えるだけでGPUを使う並列プログラムを作ろうというのがOpenACC(ACCはAccelerator)やOpenMP(Multi-Processor)である。

GPUを支える技術1

設計システムはCAD(Computer Aided Design)と呼ばれています。入社後、営業管理部門から希望して移動した営業部門は、機械系設計のCADシステムや解析(CAE)システムなどを販売する部門でした。

ドイツで開発されたCADのソフトウェアは2次元の設計・製図システムがME10、3次元の立体モデルの設計システムがME30という名称でした。ざっと35年前の恐ろしく昔の話です。このME30というシステムはソフトウェアとハードウェアで1システム2,000万円以上、年間10台~15台売ればノルマ達成という感じでした。

画像出展:「Yahoo Auction」

現代では想像もできないような価格ですが、このME30という3次元CADにはSRXというグラフィックエンジンを搭載した特別仕様のEWS(エンジニアリングワークステーション)が必要なため、これだけで1,000万円以上していたと思います。

おそらく、当時のグラフィック処理をするエンジンが、NVIDIAなどが開発するGPUにつながったのだと思います。GPUはGraphics Processing Unitという名の通りグラフィックス処理用の半導体チップですが、同時に様々なソフトウェアの技術革新もあったのだろうと思います。

そして、そのグラフィック処理エンジンから派生する様々な革新が、AIの土台となるニューラルネットワークなど、新しいITの世界を切り開こうとしているように見えます。そこにはどんな歩みがあったのか、将来の可能性はどのようなものなのか、多くの発見があると期待しこの本を購入しました。

目次 (大項目と中項目だけを書き出しています)

第1章 [入門]プロセッサとGPU

1.1 コンピュータシステムと画像表示基盤

●コンピュータ画像で表示するしくみ

●画像を表示するディスプレイ

●液晶ディスプレイ

-Column プロセッサの構造と動き

●フレームバッファとディスプレイインターフェース

1.2 3Dグラフィックスの歴史

●初期のグラフィックス

●コンピュータグラフィックスの利用の広がり

●3次元物体のモデル化と表示

1.3 3Dモデルの作成

●張りぼてモデルを作る

●マトリクスを掛けて位置や向きを変えて配置を決める

●光の反射を計算する

1.4 CPUとGPUの違い

●GPUは並列処理で高い性能を実現する

●GPUの出現

●GPUコンピューティングの出現

-整数と浮動小数点数

●GPUは超並列プロセッサ

●CPUはGPUのヘテロジニアスシステムと、抱える問題

1.5 ユーザーの身近にあるGPUのバリエーション

●携帯機器向けのGPU

●CPUチップに内蔵されたGPU

●ディスクリートGPUとグラフィックスワークステーション

1.6 GPUと主な処理方式

●共通メモリ空間か、別メモリ空間か

●フルバッファ方式か、タイリング方式か

●SIMD方式か、SIMT方式か

1.7 まとめ

-Column プロセッサと半導体の世代

第2章 GPUと計算処理の変遷

2.1 グラフィックとアクセラレータの歴史

●グラフィック処理ハードウェアの歴史

●アーケードゲーム機

●家庭用ゲーム機

●グラフィック

2.2 グラフィックボードの技術

●2Dの背景+スプライト

●BitBLT

●2Dグラフィックアクセラレータ

●3Dグラフィックスアクセラレータ

2.3 GPUの科学技術計算への応用

●ユニファイドシェーダ

●GPUで科学技術計算

●科学技術計算は32ビットでは精度不足

●CUDAプログラミング環境

●エラー検出、訂正

-Column ムーアの法則と並列プロセッサ

2.4 並列処理のパラダイム

●GPUの座標変換計算を並列化する

●MIMD型プロセッサ

●SIMD型プロセッサ

●SIMD実行の問題

●SIMT実行

-Column ARMv7のプレディケート実行機能

2.5 まとめ

第3章 [基礎知識]GPUと計算処理

3.1 3Dグラフィックスの基本

●[基礎知識]OpenGLのレンダリングパイプライン

●フラグメントシェーダ

●サンプルごとのオペレーション

3.2 グラフィック処理を行うハードウェアの構造

●Intel HD Graphics Gen9 GPUコア

3.3 [速習]ゲームグラフィックとGPU

●【ハードウェア面の進化】先端3Dゲームグラフィック・デモクラシー

●PlayStationとセガサターンが呼び込んだ3Dゲームグラフィック・デモクラシー

●DirectX 7時代

●プログラマブルシェーダ時代の幕開け

●【ソフトウェア面の進化】近代ゲームグラフィックにおける「三種の神器」

●【光の表現】法線マッピング

●【影の表現】最新のGPUでも影生成の自動生成メカニズムは搭載されていない

●【現在主流の影表現】デプスシャドウ技法

●HDRレンダリング

●HDRレンダリングがもたらした3つの効能

●ジオメトリパイプラインに改良の兆し

●DirectX Raytracing(DXR)

●DirectX Raytracingのパイプライン

3.4 科学技術計算、ニューラルネットワークとGPU

●科学技術計算の対象は非常に範囲が広い

●科学技術計算と浮動小数点演算

●浮動小数点演算の精度の使い分け

●ディープラーニングに最適化された低精度浮動小数点数

3.5 並列計算処理

●GPUのデータ並列とスレッド並列

●3Dグラフィックスの並列性

●科学技術計算の並列計算

3.6 GPUの関連ハードウェア

●デバイスメモリに関する基礎知識

●CPUとGPUの接続

●電子回路のエラーメカニズムと対策

3.7 まとめ

第4章 [詳説]GPUの超並列処理

4.1 GPUの並列処理方式

●SIMD方式

●SIMT方式

4.2 GPUの構造

●NVIDIA Turing GPUの基礎知識

●NVIDIA GPUの命令実行のメカニズム

●多数のスレッドの実行

●SMの実行ユニット

●NVIDIAのTensorコア

-Column ディープラーニングの計算と演算精度

●GPUのメモリシステム

-Column RISCとCISC

●ワープスケジューラ

●プレディケート実行

4.3 AMDとArmのSIMT方式のGPU

●AMD RDNAアーキテクチャGPU

●スマートフォン用SoC

●Arm Bifrost GPU

4.4 GPUの使い勝手を改善する最近の技術

●ユニファイドメモリアドレス

●NVIDIA Pascal GPUのユニファイドメモリ

●細粒度プリエンプション

4.5 エラーの検出と訂正

●科学技術計算の計算結果とエラー

●エラー検出と訂正の基本のしくみ

●パリティエラーチェック

●ECC

●強力なエラー検出能力を持つCRC

●デバイスメモリのECCの問題

-Column ACEプロトコルとACEメモリデバイス

4.6 まとめ

第5章 GPUプログラミングの基本

5.1 GPUの互換性の考え方

●ハードウェアの互換性、機械語命令レベルの互換性

●NVIDIAの抽象化アセンブラPTX

●GPU言語レベルの互換性

5.2 CUDA[NVIDIAのGPUプログラミング環境]

●CUDAのC言語拡張

●CUDAプログラムで使われる変数

●デバイスメモリの獲得/解放とホストメモリとのデータ転送

●[簡単な例]行列積を計算するCUDAプログラム

●CUDAの数学ライブラリ

●NVIDIA GPUのコンピュート能力

●CUDAのプログラムの実行制御

●CUDAのユニファイドメモリ

●複数CPUシステムの制御

5.3 OpenCL

●OpenCLとは

●OpenCLの変数

●OpenCLの実行環境

●カーネルの実行

●OpenCLにおけるメモリ

●OpenCLのプログラム例

5.4 GPUプログラムの最適化

●NVIDIA GPUのグリッドの実行

●メモリアクセスを効率化する

●ダブルバッファを使って通信と計算をオーバーラップする

5.5 OpenMPとOpenACC

●OpenMPとOpenACCの基礎知識

●NVIDIAが力を入れるOpenACC

●OpenMPを使う並列化

●OpenACCとOpenMP

5.6 まとめ

第6章 GPUの周辺技術

6.1 GPUのデバイスメモリ

●DRAM

6.2 CPUとGPU間のデータ転送

●PCI Express

●NVIDIAのNVLink

●IBMのCAPI

●NVIDIA NVSwitch

6.3 まとめ

-Column AMD HIP

第7章 GPU活用の最前線

7.1 ディープラーニングとGPU

●ディープラーニングで使われるニューラルネットワーク

●ディープラーニングで必要な計算とGPU

●ディープラーニングでのGPUの活用例

7.2 3DグラフィックスとGPU

●自動車の開発や販売への活用

●建設や建築での活用

●Nikeのスポーツシューズの開発

●VR、ARの産業利用

●NVIDIAのGRID

●物理的に複数ユーザーにGPUを分割するMIG

7.3 スマートフォン向けのSoC

●Snapdragon 865とSnapdragon 835

7.4 スーパーコンピュータとGPU

●世界の上位15位までのスーパーコンピュータの状況

●スーパーコンピュータ「富岳」

●Preferred Networksのスーパーコンピュータ「MN-3」

7.5 まとめ

-Column Apple M1とそのGPU

第8章 ディープラーニングの台頭とGPUの進化

8.1 ディープラーニング用のハードウェア

●ディープラーニング用のハードウェア

●低精度並列計算で演算性能を上げる

8.2 各社のAIアクセラレータ

●GoogleのTPU

●NVIDIAのTensorコア

●LeapMindのEfficiera

●Habana LabsのGoyaとGaudi

-Column RoCE Remote DMA on Converged Ethernet

●システムの拡張性

●ArmのMLプロセッサ

●CerebrasのWafer Scale Engine

8.3 ディープラーニング/マシンラーニングのベンチマーク

●ILSVRCの性能測定

●MLPerfベンチマーク

●MLPerfの学習ベンチマーク

●MLPerfの推論ベンチマーク

●MLPerfに登録された学習ベンチマークの測定結果(v0.7)

●MLPerfに登録された推論ベンチマークの測定結果(v0.7)

8.4 エクサスパコンとNVIDIA、Intel、AMDの新世代GPU

●Perlmutter

●NVIDIAのAmpere A100 GPU

●Intelは新アーキテクチャのXe GPUを投入

●AMDは新アーキテクチャCDNA GPU開発へ

8.5 今後のLSI、CPUはどうなっていくのか?

●微細化と高性能化

●チップレットと3次元実装

●CPUはどうなっていくのか

●高性能CPUの技術動向

●機械学習を使う分岐予測

●演算性能を引き上げるSIMD命令

8.6 GPUはどうなっていくのか

●GPUの今

●GPUの種類

●消費電力の低減

●アーキテクチャによる省電力設計

●回路技術による省電力化

8.7 まとめ

第1章 [入門]プロセッサとGPU ※GPU:Graphics Processing Unit

1.1 コンピュータシステムと画像表示基盤

●コンピュータ画像で表示するしくみ

・コンピュータはプログラムを実行し、フレームバッファ(メモリ)にデータを書き込む。動画はフレームをパラパラ漫画のようにして表示する。

・表示専用のメモリはVRAM(Video RAM)と呼ばれる。

・フレームバッファをディスプレイに表示するためには、ディスプレイインターフェースが必要である。

・複雑な画像の場合、データ生成、フレームバッファの書き込みには多くの計算とメモリアクセスが必要であり、高速に表示、描画させるためにプロセッサ(CPU)を補助する専用チップが開発された。これらはビデオチップや、グラフィックアクセラレータと呼ばれてきた。

●画像を表示するディスプレイ

・昔はブラウン管(CRT:Cathode Ray Tube)という一種の真空管が使われていた。現在は液晶ディスプレイや有機EL(Electro-luminescence)が使われている。

●フレームバッファとディスプレイインターフェース

・最近のGPUは表示機能、描画機能に加えてビデオのデコードやエンコード機能を内蔵しており、今はディスプレイインターフェース専用のチップは過去のものとなっている。

1.2 3Dグラフィックスの歴史

・文字だけでなく図が加わると、情報の伝達が飛躍的に容易になる。

●コンピュータグラフィックスの利用の広がり

・汎用コンピュータや専用の画像処理プロセッサの能力が向上するにつれて、より高度な画像表示ができるようになった。

・コンピュータグラフィックス(CG)は、画像の品質、動画、ゲームなど、それぞれのニーズにあったプロセッサが求められた。

●3次元物体のモデル化と表示

・3Dグラフィックスは1つの次元を固定すれば2次元になる。それにより3次元の表示機能を持つGPUが一般的になっている。1999年頃になると3Dグラフィックスに必要な機能の大部分をワンチップに収めることができるようになった。NVIDIAは「GeForce 256」などゲーム向けの3DグラフィックスLSIを発売した。

1.4 CPUとGPUの違い

●GPUは並列処理で高い性能を実現する

・CPUの演算器は数個~数十個だが、GPUの場合は数十~数千個にものぼる。すべて並列に動作させればCPUより1~2桁高い演算性能を得られる。

・メモリはGDDR DRAM(Graphics Double Data Rate Dynamic Random Access Memory)という従来のDDRメモリより1桁高いバンド幅を持つメモリを使っている。

・性能を高めるには並列に実行させるプログラムが必要である。

●GPUの出現

・1999年、NVIDIAは開発したGeForce 256をGPU(Graphics Processing Unit)と名付けた。そして、3Dの画像を描画するLSIを「GPU」と呼ぶようになった。

・GeForce 256の出現から10年くらいは、グラフィックス計算には整数演算が使われていた。その後、GPUチップに使えるトランジスタ数が増えると、浮動小数点演算器を搭載するようになり、2008年には32ビットのGPU(GeForce 8000)が一般的になった。これによりGPUは行列(マトリクス)の掛け算など、科学技術計算にも利用され始めた。さらに64ビットのGPUも開発された

●GPUは超並列プロセッサ

・デスクトップPC向けCPUとゲーム向けGPUの違い

画像出展:「GPUを支える技術」

特に印象的なのはスレッド数(1つのCPUが同時に実行できるプログラム数の最小単位)、オンチップメモリ、クロック周波数です。この差をみると、CPUではどうしようもない計算世界が存在するのが分かります。

また、最近ではGPUへの依存度を減らすためカスタムシリコン(システム・オン・チップASIC)が注目されています。

●CPUはGPUのヘテロジニアスシステムと、抱える問題

・CPUとGPUによる共同作業

-CPU:OS、I/Oネットワーク、データ入力、データ送受信(PCI)

-GPU:データ送受信(PCI)、計算、ディスプレイ

1.5 ユーザーの身近にあるGPUのバリエーション

●携帯機器向けのGPU

・CPUとGPU、その他の各種ユニットをワンチップにまとめたスマートフォン用のSoC(System on Chip)が代表的である。熱問題(冷却器がない)や使用時間を考慮し、低消費電力(1W以下)が重要である。

●CPUチップに内蔵されたGPU

・ノートPCではCPUチップにGPUが内蔵されているものが多い。消費電力は数Wから最大100W程度。

●ディスクリートGPUとグラフィックスワークステーション

・ゲーマーやデザイナーは高性能なグラフィックスを求める。そのため、CPUとは独立したPCI Expressカードなどに搭載されたGPU(ディスクリートGPU)が使われる。これにより消費電力による影響を減らし、高バンド幅のメモリを使うことができる。

1.6 GPUと主な処理方式

●共通メモリ空間か、別メモリ空間か

・GPUは高いバンド幅を必要とするため、両者が共通のメモリを利用するのは難しい。そのためメモリ空間は別というのが一般的である。

・メモリ間のデータ転送にはDMAエンジン(Direct Memory Access engine)が必要になる。

・CPUとGPUのメモリを共有することは、GPU開発メーカーの重要な開発目標になっている。

●SIMD方式か、SIMT方式か

・科学技術計算などの用途のためにNVIDIAが開発したのがSIMT(Single Instruction, Multiple Threading)という処理方式である。要素数に関わらず全ての演算器を無駄なく使えるので、SIMT方式が増えている。

AIと医療2

Chapter4 信頼するが、検証する

・GPT-4は管理業務の軽減だけでなく、患者に焦点を当てた知的で感情的なプロセスとしての医療に貢献する。しかし、その一方で、その潜在的なリスクも大きい。おそらくは当分の間、GPT-4は人間の直接の監視なしに医療現場で使用することはできないだろう。

●驚きと不安

・GPT-4に対する不安は、GPT-4のアドバイスが安全で効果的であることを、どのように保証したり証明したりできるかが分からないからである。

●臨床試験

・GPT-4には明確な人間の価値観が欠けている。それはGPT-4の中には、患者の嗜好、価値観、リスク回避、そして人間を構成する何百ものバイアス[非合理的な判断をしてしまう心理現象のこと]の明示的な表現がないからである。

●訓練生

・現時点では、GPT-4は臨床症例に対して最も善意ある人間と同じように行動し、反応する仕組みを持っているとは考えられていない。

●しかし、パートナーとしては……

・GPT-4が自律的に行動しないとしても、医療を改善する上でのGPT-4の可能性は桁外れに大きいように見える。それは医療従事者に取って替わるのではなく、補完するためである。米国の医療における人手不足の問題は深刻であり、今後10年以内に不足する医師は48,000人に達すると推定されている。医療者の燃え尽き症候群の問題も深刻である。仕事への不満、ストレス、患者との時間を増やせないことや最新の医療知識を身に付けられないことへの不満など、その重荷の中には絶え間なく更新される臨床ガイドライン、医療費の30%を消費すると推定されるほどのお役所仕事なども含まれる。このような厳しい労働環境は医療ミスの温床にもつながる。

●先導者

・GPT-4は超人的な臨床能力を有している。そして、患者の病気を引き起こしている可能性のある遺伝子を特定する専門医の役割を果たせる可能性もある。

Chapter5 AIで拡張された患者

・訓練を受けた医療従事者がGPT-4にアクセスできるようにすることと、新しいAIスーパーツールを情報の荒野に解き放ち、患者が直接利用できるようにすることは全くの別物である。

・GPT-4は人類が蓄積した医療情報を掘り起こす驚異的なルーツであり、ユーザがそれを使いたがるのは当然である。

・米国の成人の約75%がオンラインで健康情報にアクセスしており、彼らがWebMDや検索システムから「個人的な医療情報を分析できる医学的に全知全能なAI」と「患者が望むだけ長くやり取りできる新しい大規模言語モデル」へと大移動することは容易に想像できる。

●持たざる人々

・人類の半分、約40億人が十分な医療を受けられていないと推定されている。

・GPT-4やAIシステムの最も有望な側面の1つは、遠隔地への医療である。

・AI医療は最終的には医師に残された仕事が「複雑な意思決定と人間関係の管理」だけになる医療システムへと向かっていると考える研究者もいる。

●新しい三者の関係

・GPT-4の潜在的な利点には、「継続的なモニタリングが不可能」になった患者への積極的な連絡と情報やサービスの提供である。COVIDの患者をスクリーニングするという目的で実施された、パンデミック時のチャットボットの実験は、社会から疎外された人々に大規模にリーチする上でテクノロジーがどのように利用できるかを実証した。

・GPT-4を最初にどのように使うかを考えるべきである。それは理想的には「医療の助けを最も必要としているのは誰か」ということである。それは「社会的弱者のコミュニティ」かもしれない。

●情報に基づく選択

・GPT-4はあらゆる患者にとって米国の医療制度におけるもう1つの困難な側面を解決する可能性を示している。それは、適切な医療を見つけることである。これはAIが患者のパートナーとして、信頼できる公平な医療のガイドとなることを目指すということであり、1960年代のインフォームドコンセントを一歩超えた概念ある。

画像出展:「AI医療革命」

こちらは「血液検査」の結果です。専門家でないと理解するのは困難な内容です。

下のQAですが、プロンプト5-8は質問で、「この検査結果はどう?」と聞いています。また、次の質問(プロンプト5-9)では、眠れない原因について尋ねています。

そして、それぞれGPT-4が回答(回答5-8、5-9)していますが、どうみても医師から回答のように見えます。

●より良い健康

・GPT-4は「グープ(goop)」と呼ぶ「疑似科学に基づく健康アドバイスの氾濫」に対処する上でも役立つのではないか。

●セラピーAI

・「AIはセラピストであり、友人であり、恋人にさえなれる」とは、ボストン・グルーブ紙のニュース記事の見出しである。ReplikaというAIフレンドはApp Storeから1000万回以上ダウンロードされている。

・AIがセラピストに取って代われるのかは分からないが、セラピスト、特に優秀なセラピストは不足している。また、有害なセラピー(心のケア)が存在している。ロイ・パーリス博士(ハーバード大学医学部の精神医学教授)は非常に効果的なセラピストによるセラピー・セッションの記録をAIに学習させることで、その才能をより広く利用可能にできるかもしれにないと考えている。

・AIがメンタルヘルスに役立つかは「一長一短」である。軽度の不安や抑うつなどには適しているかもしれないが、重症な人には適さないと考えられる。

・AIは一次医療やオンラインCBT(認知行動療法をオンラインで提供するプログラムやサービス)でうまくいく人もいれば、治療や入院治療が必要な人もいる。

・インターネットとモバイルの時代は、地球上の人の手に情報を届けるものだった。一方、AIの時代は、地球上の人の手に知性が行き渡るようになる。その知性とは、とりわけ医療に応用できるものである。

Chapter6 もっとはるかに:数字、コーディング、ロジック

・GPT-4はUSMLE(米国医師国家試験)と同様にNCLEX(看護師国家試験)でも好成績を収めている。

●GPT-4は計算して、コードを書く

・GPT-4は点滴の問題の他、薬物の相互作用の可能性に関する質問にも答えることができる。そして、それをコンピュータプログラムの形でも説明できる。それも「アプリを作ってほしい」と頼むだけである。

・GPT-4は一般的なアプリケーションを使って計算することも得意であり、表計算ソフトの使い方にも答えることができる。

●GPT-4は不思議なことに論理的であり、常識的な推論もできる

・GPT-4は数学、統計学、コンピュータプログラミングの能力だけでなく、倫理的推論に長けている。

●GPT-4とはいったい何なのか

・GPT-4には人間の脳とは異なる制限がある。

・GPT-4の「機械学習」は電源をオフにして、新たな知識や能力を吸収しなければならない。これはトレーニングと呼ばれ、多くのテキスト、画像、ビデオ、その他のデータを収集し、特別な一連のアルゴリズムを使ってすべてのデータを抽出し、モデルと呼ばれる特別な構造にする。ひとたびモデルが構築されると、推論エンジンと呼ばれる別の特別なアルゴリズムが、例えば、チャットボットの回答を生成するためにモデルを実行に移す。

・GPT-4のニューラルネットワークの正確なサイズは公表されていないが、その規模は非常に大きく、それをトレーニングするのに十分なコンピューティングパワーを持つ組織は世界でもほんの一握りしかない。おそらく、これまでに構築され、一般に配備された人工ニューラルネットワークの中で最大のものと思われる。

・GPT-4の能力の大部分は、ニューラルネットワークの規模に起因している。

・OpenAIの技術者たちは極端なスケールが人間レベルの推論を達成する道筋となることに対して確信がない。そして、十分なスケールが達成された途端に、その多くが「ひょっこり出現」したという事実や「失敗モード(システムやモデルが予期せぬ方法で不適切に動作する状況)」が非常に不可解である理由の一端を説明している。

・人間の脳がどのように「考える」を達成するのかを、我々が理解できていないのと同様に、GPT-4がどのように「考える」のかについての多くのことを、我々は理解できないのである。

●GPT-4は単なる自動補完エンジンなのか

・GPT-4は「単なる」コンピュータプログラムである。

・GPT-4は実際に何をしているのか。「GPT-4のようなLLMは、次の単語を予測する」と言われることがある。それは、LLMは大規模統計分析を使って、これまでに起こった会話から、次に(コンピュータまたはユーザのどちらかから)吐き出される可能性が高い単語を予測する。

●しかし、GPT-4にはいくつかの絶対的限界がある

・人間は能動的に考え、世界と対話しながら学習することができる。常にオンライン、ライブである。一方、GPT-4はオフランでのトレーニングが必須である。仮に最後のトレーニングが2022年1月とすればそれ以降は何も学習していないことになる。

・GPT-4は長期記憶の欠如という限界がある。GPT-4でセッションを始める時、GPT-4は白紙の状態でセッションを行う。そして、セッションが終わると会話の内容はすべて忘れ去られてしまう。

・GPT-4はセッションの長さに制限がある。セッションサイズの上限に達すると会話はすべて中断され、新たにセッションを始めるほかない。

・人間の脳の古い記憶に関する能力は解明されていない。また、脳は体力と気力がある限り会話を続けられるが、GPT-4にはそれはできない。

●注意、GPT-4は微妙な誤りを犯す

・GPT-4には誤りは珍しいことではないので、「信頼するが、検証する」は極めて重要である。特に、数学、統計学、論理学に関しては特に注意する必要がある。

・GPT-4の確認作業は別のGPT-4とのセッションを利用する。もしくは人間が確認することである。

・GPT-4の誤りが難しい1つの要因は、人間にとって非常に難しい問題を解ける一方で、些細と思われる問題を正しく解答できない場合も少なくないからである。

・GPT-4はコードを書いたり、APIを使ったりすることができるので、ソルバーやコンパイラ、データベースなどのツールを使えるようにすると制限を克服できるかもしれない。また、医療系では病院の電子カルテシステムや医療画像データベースへのアクセス権が与えられるとGPT-4の予測可能性は向上するだろう。

●結論

・GPT-4は絶え間ない進化と改善を続けている。

・GPT-4の出力を検証することが非常に重要である。もし、検証することができないならば、GPT-4の結果を信用しない方が賢明である。

・GPT-4が実際に「考える」か、「理解する」か、「感じる」かについては、コンピュータ科学者、心理学者、神経科学者、哲学者、宗教指導者などが延々と議論し、論争していくと考えられる。そして、このような議論はとても重要である。

・今日、最も重要なことは、GPT-4のような機械と人間がどのように協力し、人間の健康を増進させるかということである。GPT-4はヘルスケアの改善に貢献する並外れた可能性を秘めている。

Chapter7 究極のペーパーワークシュレッダー

・ペーパーワークを嫌う人は多いが、医療分野で考えれば、治療に関する情報を文書化して共有し、改善に役立てるためにある。文書で物事を共有することは、治療ミスのリスクを減らし治療の効果を高める。また、病院経営には請求、送金、保険契約などの多くの事務処理が存在している。医療は厳しく規制された業界であり、政府による規制を守る方法は医療業務を文書化することである。

・医師や看護師の燃え尽き症候群は増加の一途をたどっており、職業的満足感を抱いているのは22%という調査結果も出ている(HealthDay:健康と医療に関連するニュースと情報を提供するサービス)。燃え尽き症候群の最大の原因は人員不足であるが、その次の要因は、医師の58%、看護師の51%が事務処理の問題をあげている。

おわりに

『今日は2023年3月16日、我々はこの本の執筆を終えようとしている。ありがたいことだ。つい2日前、OpenAIはGPT-4を正式に世界に公開した。

同じ日、マイクロソフトは新しいBingとEdgeのチャット機能を支えるAIモデルがGPT-4であることを明らかにした。グーグルも同日、大規模言語モデルへの開発者のアクセスを提供するPaLM APIを発表した。そのわずか1日後、アントロピック(AIの研究と開発を行う米国のスタートアップ企業)は次世代AIアシスタント「Claude」を発表した。そして今日、マイクロソフトはWord、Excel、Outlook、PowerPointのアプリケーションにGPT-4を統合することを発表した。今後数週間で、さらに多くのLLMベースの製品が市場に登場することは間違いない。AI競争は本格化しており、我々の働き方や生き方を永遠に変えるだろう

昨日、私の同僚(そして上司)であるケビン・スコットが次のような言葉を私に教えてくれた。

(それは)人間の力を大いに増大させたが、人間の善良さをあまり増大させなかった。

これはイギリスの随筆家、戯曲・文芸評論家、画家、哲学者であるウィリアム・ハズリットが1818年に発表したエッセイ「学識者の無知について」の中で書いた言葉である。私はGPT-4に、ハズリットなら大規模言語モデルとそれが人間に及ぼすであろう影響について何と言っただろうと尋ねてみた。GPT-4はこう答えた。

『GPT-4の出現によって、今日何が起きてるのか、特に人間の健康と福祉に及ぼす潜在的な影響を考えずに、ハズリットの言葉を読むことはできない。このことに関する世間の議論は、おそらく激しく騒がしいものとなるだろう。そして、本書がそうした議論に貢献しようとしても、ハリケーンに向かって叫ぶようなことになるかもしれない。しかし、本書がそのような議論に参加しようとする人たちにとって少しでも役に立てば幸いである。社会は今後、非常に重大な倫理的・法的な問題に直面することになるだろう。そのため私は、できるだけ多くの人々が、その答えを導き出せるような能力を備えることを切に願っている。我々は、AIと健康について理解している人々が積極的な役割を果たし、この新しい力を「不適切な行動」ではなく、「人間の善意」へと向ける必要がある。』

感想

AIはやはりITの革新だと思います。それは以下のように思うからです。しかし、もし、AIが無秩序に利用されるとすれば、大きなリスクを抱えることも確かだと思います。

「働く人は良い仕事をしたいと思っている。効率よく仕事をしたいと思っている。経営者は会社を維持そして成長させるため、仕事の質を上げたいと思っている。生産性を上げたいと思っている。利益を上げたいと思っている。世間からの評価を高めたいと思っている。

このためには、有能なパートナーが必要である。それは必ずしも人間でなくても問題はないのではないか。生成AIをパートナーのように有効活用したい経営者は間違いなくいる。そしてうまく活用した企業は大きな成長の機会を手にすると思う。」

AIと医療1

AIに関しては“生成AIの可能性”というブログをアップしています。そして、AIは一時的なものではなくITにとっての革新であり、発展していくものだろうと思っています。

今回の本のタイトルは『AI医療革命』なのですが、興味をもったのはAIを牽引するリーダー的存在のNVIDIAが、特にAI医療に注目しているということを知ったためです。

購入してから気づいたのですが、本のタイトルには、「ChatGPTはいかに創られたか」と書かれていました。これには少し戸惑いを感じました。おそらくそれは医療革命という響きが、医療の歴史や現状、あるいは医療に関わるシステムや業務プロセスを変革するような大きなものをイメージしていたためだと思います。

読み終えてその違和感は、本書が掲げるAI医療革命とはソフトウェア(コンピュータ言語)革命であり、医師や医療従事者の「考える」あるいは「つくる」という分野にAIが入り込み、そして支援する(共生医療)。それにより仕事の「質(正確性)」と「量(処理スピード)」を、従来の改善という小さなものではなく、大きな変革と呼べるような医療の在り方に変える。というものではないかと感じました。

IBMが“IBM Personal Computer 5150”を世に送り出したのは1981年です。これはITにおけるハードウェア&パーソナル革命と呼べるような気がします。

画像出展:「historyofinformation」

『1981年8月12日、IBMはIntel8088プロセッサをベースとしたオープン アーキテクチャのパーソナル コンピュータオフサイトリンク(PC) を発表しました』

そして、米国では1967年から、日本では1984年から研究者の間だけで使われていたインターネットですが、本格的に普及し始めたのは“Netscape”というブラウザが画期的だったからではないかと思います。その最初のリリースは1994年です。IBMのPC5150のリリースから13年後、これはネットワーク&モバイル革命のように思います。

画像出展:「日経XTECH」

ご参考:“なんかいウェブ研究所”

私はSEではないので技術的なことは分かりませんが、メインフレームと呼ばれる大型汎用システムの言語はCOBOLだったと思います。一方、オープンシステムでマルチタスクが特長だったUNIXシステムに関しては、Fortran、C++、Javaといったコンピュータ言語が有名だったと思います。

一方、AIで使われている言語は全く新しいタイプの言語であり、LLM(大規模言語モデル)と呼ばれています。生成AIにとってLLMはまさに無くてはならないもので、ニューラルネットワークで構成されるコンピュータ言語モデルとされています。このニューラルネットワークとは生物の学習メカニズムを模倣した機械学習法とされており、今までのコンピュータ言語とは発想が全く異なります。このことが、AIはソフトウェア(コンピュータ言語)革命ではないかと考えた理由です。

画像出展:「@IT」

『AIにおける人工のニューラルネットワークは、人間の脳が持つ神経ネットワーク(=生体ニューラルネットワーク)を簡易的に模倣、もしくはヒントにしたものです。深層学習に至るまでに、人工ニューラルネットワークは徐々に進化してきました。』

画像出展:「QuadCom」

“【IT最新トレンド】対話型AIとは何かを分かりやすく解説!”

『従来のAIは、人間がルールや指示を明示的に与えて学習します。一方、大規模言語モデルは、膨大なデータ(パラメーター)から自律的に学習します。この違いにより、大規模言語モデルは従来のAIよりも柔軟で、幅広いタスクを実行することができます。』

目次

序文 OpenAI サム・アルトマン

Chapter1 ファーストコンタクト

●GPT-4とは何か

●しかし、GPTは実際に医療について何か知っているのか

●医学の専門家も非専門家も使えるAI

●AIとの新たなパートナーシップは、新たな問いを投げかける

●ザックとその母に戻る

Chapter2 機械からの薬

●医療機関の新しいアシスタント

●GPT-4はつねに真実を語るのか

●臨床医のインテリジェントなスイスアミーナイフ

●給付金への説明

●医療の実践における伴走車

●GPT-4は現在進行形

Chapter3 大いなる疑問:それは、「理解」しているのか

●大いなる疑問:GPT-4は本当に自分の言っていることを理解しているのか

●常識的推論、道徳的判断、心の理論

●現実には限界がある

●では、大いなる疑問についてはどうだろう

Chapter4 信頼するが、検証する

●驚きと不安

●臨床試験

●訓練生

●しかし、パートナーとしては……

●先導者

Chapter5 AIで拡張された患者

●持たざる人々

●新しい三者の関係

●情報に基づく選択

●より良い健康

●セラピーAI

Chapter6 もっとはるかに:数字、コーディング、ロジック

●GPT-4は計算して、コードを書く

●GPT-4は不思議なことに論理的であり、常識的な推論もできる

●GPT-4とはいったい何なのか

●GPT-4は単なる自動補完エンジンなのか

●しかし、GPT-4にはいくつかの絶対的限界がある

●注意、GPT-4は微妙な誤りを犯す

●結論

Chapter7 究極のペーパーワークシュレッダー

●GPT-4は、紙の受付票を代替する

●GPT-4は診療記録の作成に役立つ

●GPT-4は品質向上を支援できる

●GPT-4は医療提供のビジネス面を支援できる

●GPT-4は価値基準医療の仕組みに役立つ可能性がある

●GPT-4に医療ビジネスの意思決定を任せられるか

Chapter8 より賢いサイエンス

●例:新しい減量薬の試験

●研究のための読書と執筆

●適格化のためのツール

●臨床データの分析

●消えたデータ

●基礎研究

Chapter9 安全第一

Chapter10 リトル ブラック バッグ

おわりに

序文 OpenAI サム・アルトマン

・本書は、GPT-4の汎用的な能力がどのように医療とヘルスケアに革命をもたらされるかを包括的に概説している。

・医療アプリケーションにおけるGPT-4の安全で倫理的かつ効果的な使用法に関する初期の実践指針を示し、その使用をテスト、認証、監視するための緊急の取り組みを呼びかけている。

Chapter1 ファーストコンタクト

・2022年秋、そのAIシステムはまだOpenAIが秘密裏に開発中だった。

・医療にどのような影響を与え、医学研究を変革する可能性があるかを探る。

・診断、診療記録、臨床試験のほぼすべての領域。

●GPT-4とは何か

・初心者ユーザはAIシステムを一種にスマートな検索エンジンのように捉えることが多いようだ。

・GPT-4は検索エンジンと統合できる。

・GPT-4の会話継続能力は素晴らしい。

・GPT-4は論理学や数学の問題を解くことができる。

・GPT-4はコンピュータプログラムを書ける。

・GPT-4はスプレッドシート、フォーム、技術仕様書など解読できる。

・GPT-4は外国語間の翻訳ができる。

・GPT-4は要約、チュートリアル、エッセイ、詩、歌詞、物語を書ける。これらはChatGPTより高度にこなす。

・GPT-4は複雑な数学の問題を解く一方で、単純な算数に間違えることもある。

・GPT-4は賢さと愚かさという二律背反の問題は、特に医療において最大の課題の一つである。

・携帯電話を忘れたような感覚はGPT-4にも言える。GTP-4がないと医療が成り立たない、手詰まりになる、そのような感覚を人間の健康という領域において共有することが本書の目的の一つである。

・GPT-4は新しい能力だけでなく、新しいリスクも提供する。

・GPT-4は出力の正しさを検証することが非常に重要である。

・GPT-4は自分自身の仕事と人間の仕事を見て、その正しさをチェックすることに長けている。

・医療は人間とAIの連携が求められる分野である。GPT-4だけでなく、人間によるエラーを減らすため、GPT-4をどのように使うか、事例とガイダンスが求められる。

・問題の核心にあるのは、人間と機械の新しいパートナーシップ、「共生医療」である。

●しかし、GPTは実際に医療について何か知っているのか

・GPT-4を医療に使う場合、GPT-4は医療について本当は何を知っているか、ということが大きな問題である。1つ確かなことは、GPT-4は医学の専門的な訓練を受けていないということである。

・医学的訓練を受けたGPT-4というアイデアは、OpenAIの開発者だけでなく、多くのコンピュータ科学者、医学研究者、医療従事者にとって非常に興味深いものである。その理由の1つは、GPT-4がどのような医学的「教育」を受けてきたかの正確な理解が、人間の医者についてと同様に重要なことが多いからである。

・「相関関係は因果関係を意味しない」。この区別は医療において決定的に重要である。例えば、パスタをたくさん食べると高血糖になるか、それとも単に相関関係があるだけで、根本的な原因は別にあるのかを知ることは重要である。GPT-4が因果関係の推論が可能かという問題は、本書の範囲外であり、まだ決着がついていないと言うのが適切である。

●医学の専門家も非専門家も使えるAI

・GPT-4は自らの回答を「易しく書き直して」、医学の素人も含めて、様々な人がアクセスできるようにすることが可能である。

・感情を想像し、人に共感できることがGPT-4の最も興味深い点の1つである。これは人の心の状態を想像する能力に関係しているかもしれない。このようなAIシステムとのやりとりについては、ときに機械による人間の感情の評価を「不気味」に感じることもあるだろう。

・GPT-4は不可解な診断例や難しい治療法の決定や臨床事務にも役立つが、最も重要なことは「患者との対話」において医師を支援する方法を見出したことだろう。GPT-4はしばしば驚くべき明晰さと思いやりをもってそれを実現する。

●AIとの新たなパートナーシップは、新たな問いを投げかける

・『ここまでで、GPT-4がまったく新しいタイプのソフトウェアツールであることはおわかりいただけたと願う。GPT-4の前に登場したヘルスケア向けのAIツールは、放射線スキャンを読み取ったり、患者記録のコレクションから入院リスクの高い患者を特定したり、診療録を読んで正しい請求コードを抽出し、保険請求のために提出したりといった特殊なタスクをこなしたりするものが多かった。このようなAIの応用は、重要かつ有用なものだ。何千人もの命を救い、医療費を削減し、医療に携わる多くの人々の日々の体験を向上させてきたことは間違いない。

しかし、GPT-4は、まさに別種のAIである。GPT-4は、特定のヘルスケアタスクのために特別に訓練されたシステムではない。実際、医療に関する専門的なトレーニングは一切受けていない。GPT-4は、従来の「狭義のAI」ではなく、医療に貢献できる初めての「汎用的な人工知能」なのだ。この点で、本書が扱う真の問いは、次のように要約される。すなわち、もし医療に関するほぼすべてを知る「箱の中の脳」があったら、それをどのように使うか、である。

しかしながら、もう1つ、より根本的な疑問がある。これほど重要かつ個人的かつ人間的で大きな役割を果たす資格が、人工知能にはどのくらいあるか、である。我々は皆、医師や看護師を信頼する必要がある。そのためには、我々をケアする人たちが良い心を持っていることを知る必要がある。

それゆえ、GPT-4が持つ最大の疑問、そして最大の可能性が見えてくる。GPT-4はどのような意味で「善良」なのだろう。そして、結局のところ、このようなツールは、我々人間をより良くしてくれるのだろうか。』

●ザックとその母に戻る

・『GPT-4をはじめとするAIが「考える」「知る」「感じる」のか、コンピュータ科学者、心理学者、神経科学者、哲学者、そしておそらく宗教家までもが、延々と続けるだろう。知性と意識の本質を理解しようとする我々の願いは、人類にとって最も根源的な旅の1つであることはたしかである。しかし、最終的に最も重要なのは、GPT-4のような機械と人間がどのように協力し、パートナーシップを結び、人間の状態を改善するために共同で探求していくのかということだ。』

Chapter2 機械からの薬

・GPT-4は文句を言ったり、叱ったりするのが好きではない。

・GPT-4と「関係」を持つという考え方は、本書の核心的な問いかけの1つであり、おそらく物議を醸すだろう。従来の常識では、思考し感情を持つ知覚的存在としてAIシステムを捉えるのは間違っており、AIを擬人化することには本当に危険が伴うと言われている。この問題は最も個人的な事柄の1つである医療において、特に重要だと思われる。

・GPT-4は常に変化し改善している。

●医療機関の新しいアシスタント

・米国の医療従事者の仕事量は20年間で劇的に増加した。医師や看護師は助けを必要としている。

・医療現場の日常業務の多くは、過酷で単調な事務作業などに追われている。

●GPT-4はつねに真実を語るのか

・GPT-4が出す間違った回答の問題点は、その答えが正しく見えることである。なぜなら、説得力のある方法で提示されるからである。

・GPT-4が医療現場のどこで使用すべきか、また医学のあらゆる側面、さらには医学研究論文などのレビューにも当てはまることである。

・GPT-4のような汎用AI技術は、教育的な推測や情報に基づく判断が必要とされる状況に巻き込まれる。

・医師-患者-AIアシスタントの「三位一体」が、医師-患者-AIアシスタント-AI検証者へと拡張される可能性がある。

●臨床医のインテリジェントなスイスアミーナイフ

・GPT-4は診療記録だけでなく、様々なフォーマットで質の高い診察後のサマリー(患者の診療情報や入院・退院時の概要、治療の経過などを簡潔にまとめた文書)を作成できる。

・GPT-4は会話に非常に長けているので、患者の状態や病歴に基づいて、内容の変更や推奨事項を提案することも可能である。

●給付金への説明

・GPT-4はデータを説明、比較、パーソナライズ、最適化し、フィードバック、推奨、精神的サポートを提供することで、医療費、検査結果、健康アプリなど消費者が自身の健康データを解読し、管理するのを支援できる。

●医療の実践における伴走車

・GPT-4はエビデンスに基づいた仮説を立て、複雑な検査結果を解釈し、一般的な疾患だけでなく稀な疾患や生命を脅かす疾患の診断も認識し、関連する参考文献や説明を提供することができる。

・GPT-4は高度に専門的な研究論文を読み、非常に洗練された議論を行うことができる。

・GPT-4の“ユニバーサル・トランスレーター”機能は、医師や看護師を目指す人々や一般の人々に対して、医学知識の普及や医学教育に役立つ可能性がある。

・GPT-4は医学雑誌の記事を読み、小学6年生の理科の授業にふさわしい要約とクイズを書くことができる。

・GPT-4は高度な医学研究の場で、推論を駆使して議論を促し、次の研究ステップの可能性を議論し、可能性のある答えを推測することができる。

・GPT-4はインフォームドコンセントのような倫理的概念にも精通していると思われる。

・GPT-4は全体として、透明性、説明責任、多様性、協調性、論理性、尊重の重要性について核心的な理解を持っている。

●GPT-4は現在進行形

・GPT-4は急速に進化しており、ここ数カ月の調査においても、その能力が著しく向上しているが、未完成であり、今後も絶え間なく進化し続けるだろう。

・本書の最大の目的は、この新しいAIが、ヘルスケアや医療、そして社会のその他の分野で果たす役割について、今後極めて重要な社会的議論に貢献することである。しかし、最も重要なことは、GPT-4自体が目的ではなく、新たな可能性と新たなリスクを併せ持つ世界への扉を開くものである。

・今後、GPT-4を凌ぐ有能なAIシステムは登場するだろう。GPT-4は加速度的に強力的になっていく汎用AIシステムの最初の一歩に過ぎないというのが、コンピュータ科学者たちの共通認識である。

・人工知能の進化に合わせ、医療へのアプローチをどのように進化させるのがベストなのかを理解することである。

Chapter3 大いなる疑問:それは、「理解」しているのか

・GPT-4が優れた会話システムであるのは、会話の全体像を把握している点である。これは今までのAI言語システムと大きく異なる点である。

・何のガイダンスもない場合、GPT-4はその回答を簡潔にするか、あるいは拡大解釈するかを自分で決めなければならない。

・GPT-4は口調を調整し、象徴を想起させ、進行中の会話の「雰囲気」に合わせるという能力を持っている。

●大いなる疑問:GPT-4は本当に自分の言っていることを理解しているのか

・GPT-4は読み書きを理解しアウトプットに意図はあるのか、それとも言葉をつなぎ合わせた無心のパターンマッチングなのかが疑問であるが、多くのAI研究者の見解は後者であり、ディープラーニングだけでは限界があると考えている。しかしながら、科学の問題としてこの「大いなる疑問」に答えるのは驚くほど難しい。そして、この種の問いは、科学的、哲学的議論の的であり、この疑問は長く続くものと思われる。

・GPT-4は詩を書くより分析する方が、文章を作成するより、それを見直す方が得意のようである。

・GPT-4が自分の意志を持っているとは思えないが、確信的な捏造や省略、さらには過失もある。このことは検証を必要とする理由である。

●常識的推論、道徳的判断、心の理論

・GPT-4は理解していないという根拠には、具体的な経験の欠如がある。また、より高度な知性、例えば、物理的世界における推論、常識、道徳的判断などにおいての限界は長年の研究結果もある。

・GPT-4はイエスかノーの答えを求める質問に応じないことによって、「自分の意思」を示しているようである。

●現実には限界がある

・今の所、「理解」という問題に決着をつけられていないが、GPT-4の推論能力にはいくつかの現実的な限界がある。

・GPT-4は数学において知性と無知が混在した不可解な動きを見せることがある。

●では、大いなる疑問についてはどうだろう

・GPT-4のように純粋に言語だけで訓練されたAIシステムは、「理解」していないという見解は正しいと思う。そして、大いなる疑問に関する全体的な科学的コンセンサスはその方向性に傾いている。しかしながら、少なくともGPT-4に関しては、これを証明することは意外に難しい。

・『数ヶ月にわたる調査の結果、私[ピーター・リー]は、最新の科学的研究によるテストでは、GPT-4が「理解が欠けている」ことを証明できないという結論に達した。そして、実際、我々がまだ把握していない、真に深遠な何かが起こっている可能性は十分にある。GPT-4は、我々がまだ特定ができていない何らかの「理解」と「思考」を持っているのかもしれない。ただ、1つ確実に言えるのは、GPT-4はこれまでに見たことのないものであるということだ。そして、GPT-4を、「単なる大きな言語モデル」として片付けるのは間違いであるということだ。』

・『大いなる疑問に対する回答や、知能と意図性についての、おそらくさらに大いなる疑問は、我々の科学的・哲学的探求の中心にある。一方で、最終的に最も重要なのは、GPT-4のようなAIシステムと我々の関係が、我々の心や行動をどのように形作るかということかもしれない。人間のように「理解」できるかに関わらず、GPT-4は、4章[信頼するが、検証する]で見るように、診療所から研究室に至るまで、我々の理解を大いに助けてくれるだろう。』

リーナス・トーバルズ

GPU(Graphics Processing Unit)の開発・製造において、生成AIのリーディングカンパニーであるNvidiaによるArm買収断念の報道は2022年1月でした。現在、ソフトバンク配下のArm社は英国ケンブリッジに本社を置く、RISC(縮小命令セットコンピューター)チップの開発に特化した企業で、携帯電話やスマートフォンのほとんどの製品の中に入っています。

このArmの対抗馬として期待されているのがオープンソースのRISC-Ⅴです。このRISC-Ⅴ ISA(命令セットアーキテクチャー)を利用することにより自由にCPUを開発することができます。しかも、設計したCPUをオープンソースにする必要はなく、商用ライセンスのCPUコアを作ることができます。

※オープンソース:ソフトウェアを構成しているプログラム「ソースコード」を無償で一般公開すること。

※“NVIDIA’s secure RISC-V processor”(Youtube[英語])

『Security is key to many of NVIDIA’s markets. Example applications are protecting video and gaming IP, keeping private data on shared servers from leaking, and safety of self-driving cars. NVRISCV is at the core of NVIDIA’s security architecture. It is a RISC-V core with closely coupled co-processors that incorporate many security features to protect against a variety of attacks. Some features are architectural and we are proposing those as RISC-V specifications; others are implementation specific. We believe that RISC-V is ideally positioned to standardize around a set of security specs and best practices, helped by transparency and joint development by the community, inherent to its open source nature.』

以下は上記の英文をDeepLを使って翻訳した文章です。

『セキュリティは、エヌビディアの多くの市場にとって重要です。アプリケーションの例としては、ビデオやゲームIPの保護、共有サーバー上のプライベートデータの漏洩防止、自動運転車の安全性などがあります。NVRISCVは、NVIDIAのセキュリティ・アーキテクチャの中核です。これは、密接に結合したコプロセッサを持つRISC-Vコアで、さまざまな攻撃から保護するために多くのセキュリティ機能を組み込んでいます。いくつかの機能はアーキテクチャ上のものであり、私たちはそれらをRISC-V仕様として提案しています。私たちは、RISC-Vが、そのオープン・ソースという性質に固有の透明性とコミュニティによる共同開発によって、一連のセキュリティ仕様とベスト・プラクティスを標準化するのに理想的な位置にあると信じています。』

日本HPで営業していたのは約12年前なのですが、オープンソースと言われればソフトウェアの話しという認識しかなかったため、CPUというハードウェアの世界にもオープンソースが入り込んでいるという事実に大変驚きました。

オープンソースと言われれば、私の場合Linuxです。IBM社がLinuxを核にサーバーの長期計画を発表したのは2001年でした。HP社はUNIX(HP-UX)が主力であったという経緯もあり、Linuxに対しては消極的でした。SEの評価はLinuxは軽く優れたOS(オペレーティングシステム)というものであり、製品品質に大きな懸念はなかったのですが、メーカーサポートという面で営業としてはなかなか難しい製品となっていました。

このような懐かしい昔話を思い出していて、ふと気になったのが、「今、Linux、特に開発者のリーナス・トーバルズはどうなっているのだろう?」という疑問です。

『それがぼくには楽しかったから』、これがリーナス・トーバルズの本の題名です。なお、原題は『JUST FOR FUN』です。

画像出展:「Wikipedia」

Linus Benedict Torvalds

『フィンランド、ヘルシンキ出身のアメリカ合衆国のプログラマ。Linuxカーネルを開発し、1991年に一般に公開した。その後も、公式のLinuxカーネルの最終的な調整役を務める。』

目次

謝辞

序章 人生の意味Ⅰ

第1部 オタクの人生

第1章 眼鏡と鼻と

第2章 初めてのプログラミング

第3章 フィンランドの冬に

第4章 トーバルズ家誕生秘話

第5章 高校時代

第6章 大学と軍隊

第7章 フィンランド再び

第2部 オペレーティング・システムの誕生

第1章 シンクレアQL来る

第2章 人生を変えた本

第3章 ユニックスを学ぶ

第4章 三台目のコンピュータ

第5章 プログラミングの美しさ

第6章 ターミナル・エミュレーション

第7章 誕生

第8章 アップロード

第9章 著作権の問題

第10章 ミニックス対リナックス

第11章 ウィンドウとネットワーク

第12章 恋人!

第3部 舞踏会の王

第1章 初めてのアメリカ

第2章 商標登録

第3章 就職

第4章 シリコンバレーにようこそ

第5章 リナックスの成功

第6章 不協和音

第7章 株式公開

第8章 コムデックス

第9章 リナックス革命は終わったか?

第10章 押しつけるな!

第11章 舞踏会

第12章 サポート

第13章 知的財産権

第14章 コントロール戦略の終焉

第15章 楽しみが待っている

第16章 なぜオープンソースこそ筋が通っているのか

第17章 名声と富

終章 人生の意味Ⅱ

ブログはリーナス・トーバルズがオープンソースに対し、どう思っているのかに注目しました。

第3部 舞踏会の王

第16章 なぜオープンソースこそ筋が通っているのか

●『IBMがパーソナル・コンピュータを開発したとき、何気なく、そのテクノロジーをオープンにしたので、誰でも複製を作れるようになったんだ。そのたった一つの行動は、PC革命に拍車をかけただけじゃなく、やがて情報革命、インターネット革命、ニュー・エコノミ―(なんと呼ぶにせよ、いま世界中で大きな変化を引きおこしているもの)を順に呼び寄せる結果となった。

これは、オープンソース精神から生み出される限りない利益というものを、もっともよく表している。IBM PCはオープンソースのモデルとして開発されたわけじゃないけど、オープンにされたことで、個人や企業が互換機を作り、改良し、売ることができるようになり、オープンソース・テクノロジーの好例となったんだ。

オープンソース・モデルの一番純粋な形では、誰でもプロジェクトの開発や市場性開発などに参加できる。リナックスは明らかにそのもっとも成功した例だ。ヘルシンキのぼくの散らかった寝室から始まり、成長して、有史以来最大の共同プロジェクトにまでなった。その始まりには、コンピュータのソースコードは自由に共有すべきだと信じるソフトウェア開発者に共通の理念があった。その裏付けとなったのが、この運動の強力な武器としての一般公有使用許諾書(GPL―旧来的な著作権に反対するもの)だった。リナックスは発展し、最高のテクノロジーを開発し続ける一つのモデルになった。そして、リナックスがウェブ・サーバー用OSとして次々と採用されていることや、株式公開での予想外の好評でもわかると思うけど、リナックスはさらに発展して、広く市場に受け入れられるようになったのだ。』

●『オープンソースという手法を人々が初めて耳にしたとき、それはばかげたものに聞こえたようだ。だから、オープンソースの長所が理解されるのに何年もかかった。

ぼくらは理念があって、オープンソースを売り込んだわけじゃない。オープンソースこそ最高のテクノロジーを開発し、改良する最良の方法だとわかってきたので、その理念が世間の注目を集めだしたのだ。

いまや、その理念は市場で評価を得つつあり、その評価のおかげでオープンソースがますます受け入れられるようになってきている。さまざまな付加価値サービスをおこなう会社が作られるようになり、それらの会社はテクノロジーを普及させる手段としてオープンソースを利用することができた。お金が転がりこむと、世間は信じるようになるもんだ。

オープンソースというジグゾーパズルの中で、一番理解されていないピースの一つは、どうしてこんなに大勢のプログラマーが、まったくの無報酬で働こうとするのかってことだろう。

順序として、その原動力について述べておこう。多少なりとも生存が保証された社会では、お金は最大の原動力にはならない。人は情熱に駆り立てられたとき、最高の仕事をするものだ。楽しんでいるときも同じだ。これは、ソフトウェア技術者だけじゃなく、劇作家、企業家にも当てはまる真実だ。オープンソース・モデルは、人々に情熱的な生活を送るチャンスを与える。楽しむチャンスも、さらに、たまたま同じ会社で机を並べている数人の仲間とではなく、世界で最も優秀なプログラマーたちと仕事をするチャンスも、オープンソースの開発者たちは、仲間からいい評価を得ようと懸命に努力する。こうしたことは大きな原動力になるに違いない。』

●『オープンソース現象を理解する一つの方法がある―それは、何世紀も昔(現代の話しではないけれど)、科学が宗教界からどのように見られていたかを考えることだ。科学は、最初のうち、何か危険で、破壊的で、反対体制的なものと見なされた―ソフト会社は時々、オープンソースをそんなふうに見ている。科学は宗教体制を攻撃しようとして生まれたわけじゃなかった。それと同じように、オープンソースだってソフトウェア体制を破壊するために考えだされたわけじゃない。オープンソースは、最高のテクノロジーを生み出すために、そしてそのテクノロジーがどこに行くかを見守るために存在するんだ。』

●『オープンソースは理にかなっている。人々は、言動の自由について、屁理屈をこねたりはしない。自由こそ、人々が生命をかけて守ってきたものなのだから。自由はいつでも、生命をかけて守るべきものだ。しかし、はなっから自由を選択するのもまた簡単なことじゃない。オープンソースについても同じことがいえる。オープンにするかどうか、決定を下さなくてはならない。最初からオープンにするという立場に立ってみると危なっかしくてしようがないが、実際にやってみると、その立場はずっと安定したものになっている。』

ご参考2:“Android (オペレーティングシステム)”

画像出展:「Wikipedia」

『Androidは、Googleが開発した汎用モバイルオペレーティングシステムである。Linuxカーネルやオープンソースソフトウェアがベースで、主にスマートフォンやタブレットなどのタッチスクリーンモバイルデバイス向けにデザインされている。』

※カーネル:OSの中核。基本機能を担う部分。

画像出展:「ZDNET」

『今やLinux Foundationは、Linux以外にも1000以上のオープンソースプロジェクトを抱えている。しかし、昔からこうだったわけではない。2007年に設立された頃のLinux Foundationは、ほぼ完全にLinuxのためだけの団体だった。当時からずっとLinux Foundationのエグゼクティブディレクターを務めているJim Zemlin氏は、先日ウェブで公開されたDell Technologiesのデベロッパーコミュニティ担当マネージャーBarton George氏との対談の中で、同財団は創設に関わった人々の想像をはるかに超えて拡大してきたと語った。』

生成AIの可能性

AIとは人工知能(Artificial Intelligence)ですが、そもそもよく分かっていません。特に知りたいことはビジネスに対するインパクトの大きさです。一過性の盛り上がりなのか、“クラウド”のように主流としてITビジネスをリードしていくような革新なのかということです。

購入したニュートン別冊は、2018年5月発行なので少々古いのですが、図表も多く内容的にも興味深いものでした。

生成AI(Generative AI)については、NRI(野村総合研究所)さまのサイトをご紹介させて頂きます。“生成AIとは” 3分40秒の動画もあり、大変勉強になります。

こちらのDOORSの寄稿は非常に具体的です。(執筆者はブレインパッドの高田洋平様です)

ブログで取り上げたのは目次の黒字の個所です。

目次

1 基礎から学ぶ人工知能

●人工知能の分類

●人工知能の歴史

●ヒトとコンピューターの画像認識①~②

●ヒトの視覚野のしくみ①~②

●ディープラーニング

●機械学習①~②

●ディープラーニングの未来①~②

2 人工知能の最新応用技術

●人工知能の進化

●将棋プログラム

●アルファ碁

●保健医療分野におけるAIの活用

●人工知能の病理診断

●人工知能の内視鏡検査

●人工知能の眼底検査

●自動運転 ※ばっちゃまの米国株

●人工知能のひび割れ点検

●人工知能の惑星探査

3 人工知能の未来

●人工知能とセキュリティ

●人工知能と公平性

●人工知能とプライバシー

●汎用人工知能①~②

●シンギュラリティ

4 人工知能の新領域へ

●インタビュー 山川 宏博士

人間と調和できる人工知能をつくりたい

●インタビュー 金井良太博士

AIに意識をもたせることで意識の本質にせまりたい

●インタビュー 山本一成氏

AIが将棋の可能性を広げてくれた

●インタビュー 坊農真弓博士

「ロボットは井戸端会議に入れるか」会話にあるルールを解き明かしたい

●インタビュー 井上智洋博士

AIが人間を仕事から「解放」してくれる

●インタビュー 佐藤 健博士

AIに裁判の結果の理由を説明させる

●インタビュー 平野 晋博士

AIに常識や倫理観、感情は必要か

1 基礎から学ぶ人工知能

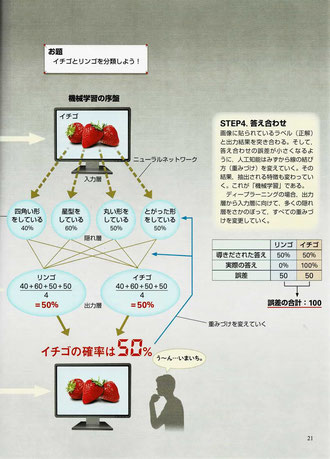

●ヒトとコンピューターの画像認識①~②

私たちは、どのように画像を認識している?

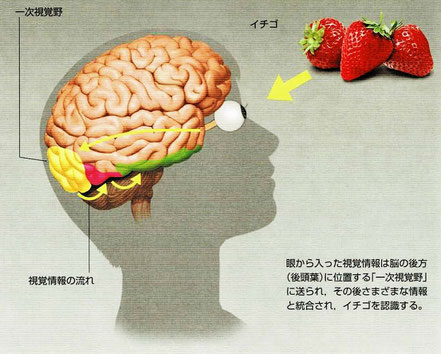

・自動運転や医療診断に欠かせないのは画像認識です。この画像認識を可能にし、人工知能の飛躍的進化をもたらしたのが「ディープラーニング」です。例えば、イチゴを見た瞬間にすぐにイチゴだと分かるのは、眼から入った視覚情報が脳の後方(後頭葉)にある「一次視覚野」に送られ、さまざまな情報と統合されてイチゴと認識されるからです。

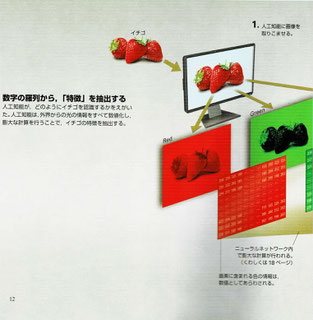

コンピューターはディープラーニングで特徴を抽出

・従来のコンピューターは、足し算や掛け算などの計算を大量に行うことはできますが、瞬時にイチゴをイチゴであると認識することはできません。

・ディープラーニングはイチゴの画像をすべて数値化し膨大な計算を行うことで、イチゴの特徴を抽出します。

まず、イチゴの画像を非常に細かい画素(ピクセル)に分け、その画素が画像のどこに位置するのかといった「位置情報」と、その画像は何色なのかといった「色情報」を持った数値として処理します。イチゴの画像もコンピューター内では、ただの数学の羅列というわけです。

・イチゴの特徴には、「表面につぶつぶがある」「丸みをおびた三角の形をしている」といった特徴があります。これらの特徴を抽出する必要があるのですが、従来の人工知能ではこの「特徴の抽出」を行うことは難しく、研究者が人工知能に「イチゴとは赤いもの」「イチゴには緑色のへたがついている」など逐一、ルールを教える必要がありました。しかしながら、イチゴの特徴を完全に言語化することは不可能であり、精度よく認識できる人工知能を開発することはできませんでした。

・ディープラーニングでは、脳の構造を模した「ニューラルネットワーク」という方法を用いて、特徴を自動で取り出すルールを自ら獲得することができます。つまり、「特徴の抽出」を行うことができるのです。

●ディープラーニング

コンピューターの中に神経網をつくりだす「ディープラーニング」

・ニューラルネットワークとは神経回路を模してつくられたシステムです。

・ニューラルネットワークは、データを受け取る「入力層」、学習内容に応じてネットワークのつながり方を変える「隠れ層」、そして最終データを出す「出力層」に分けられます。それぞれの層は、「ノード」とよばれる仮想的な領域からなります。ノードでは以下のような計算が行われ、流れる情報の量が制御されます。

これは、人間におけるニューロンのはたらきに相当します。このニューラルネットワークを何層にも重ねる(深くする)ことで作られるシステムが「ディープラーニング」です。ディープラーニングは脳の視覚野と同じように、入力層に近い部分では単純な形しか判別できません。しかし層を重ねることで、より複雑な特徴を得ることができます。そして最終的にコンピューターは、イチゴそのものの概念を手に入れることができるようになります。このようにディープラーニングは、視覚野が行う情報処理のしくみに非常に似ています。

●機械学習①~②

人工知能の“学習”とは、出力結果と正解との誤差小さくすること

・人工知能は、最初は画像からイチゴの特徴を正しく抽出することも、正しい重みづけをすることもできないので、人工知能はイチゴとリンゴを判別することはできません。そこで、分類した結果の答え合わせを行い、正解との誤差を小さくできるように、重みづけを変えていきます。

コンピューターが“学習”するしくみを見てみよう

・「機械学習」とは、人工知能に試行錯誤を繰り返させ、正しい結果が出せるようにノードとノードの重みづけ徐々に変化させていくことを指します。

・イチゴとリンゴを分類する方法を見てみます。

-学習前の人工知能は重みづけがないので、イチゴがもつ特徴が何か(画像のどこに注目するか)も分かっていません。

[STEP1.画像入力]:イチゴの画像を入力する。この画像には「イチゴ」のレベルが貼られている。

[STEP2.分類]:初期段階では、リンゴとイチゴを分類する特徴が抽出できず、適切な重みづけも不明である。人工知能はすべてを足し合わせ平均をとる。

-人工知能が間違ってリンゴと判定したとしましょう。

[STEP3.結果の出力]:リンゴである確率とイチゴである確率を比較し結果を出す。今回の場合は50%なので判別できない。

-正しい答え(イチゴ)を導き出せるように調整を加えていきます。

[STEP4.答え合わせ]:画像に貼られているラベル(「イチゴ」)と出力結果を突き合わせる。そして、答え合わせの誤差が小さくなるように、人工知能は自ら線の重みづけを変えていく。その結果、抽出される特徴も変わっていく。これが「機械学習」である。ディープラーニングの場合、出力層から入力層に向けて、多くの隠れ層をさかのぼってすべての重みづけを変更していく。

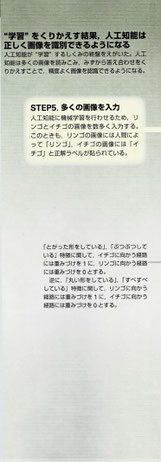

インターネットの拡大が人工知能を賢くした

・人工知能は、何百枚、何千枚と学習を繰り返すことで、徐々に正しい答えを導き出せるようになります。

[STEP5.多くの画像を入力]:人工知能に機械学習を行わせるために、リンゴとイチゴの画像を数多く入力する。このときも、リンゴの画像には人間によって「リンゴ」、イチゴの画像には「イチゴ」と正解ラベルが貼られている。

[STEP6.学習によって適切な特徴と重みづけを得る]:数多くの画像について一つずつ、分類しては答え合わせを行うことで、誤差を小さくしていく。今回の場合、当初の誤差の合計は100だったのに対し、機械学習を繰り返すことで、誤差の合計が30になっていることが分かる。このような計算によって、人工知能は適切にリンゴとイチゴを分類することができるようになる。

・長年、ディープラーニングは実用に耐えるほどの精度が出せないという問題を抱えていました。その理由は、層が深くなるにつれて、答え合わせの結果がうまく隠れ層に伝わらず、重みづけを最適化できなかったためです。

しかし近年、答え合わせの方法を改良したり、本格的な機械学習を行う前に、人工知能を“プレトレーニング”したりすることで、非常に効率よく学習を行うことができるようになりました。

また、インターネットの拡大とともに、使用できる画像データが爆発的に増えたことで、容易に機械学習を行うことができるようになったり、人工知能が行う計算に特化したプロセッサ(中央処理装置)の開発が進んだりしたことも、現在、人工知能の性能が劇的に向上している大きな要因です。

●ディープラーニングの未来①~②

ディープラーニングの活用例

・声の正体は「音波」であり、周波数という数値で表すことができます。この周波数を人工知能に取り込ませることで、「音声認識」が可能になります。iPhoneのSiriなどが該当します。

・日本語や英語の単語は「文字コード」として数値に置き換えられ、翻訳のような「自然言語処理」に利用されています。2016年、Google社はウェブ上で利用できるGoogle翻訳にディープラーニングを用いることで、翻訳の精度を劇的に向上させました。

・囲碁ソフト「AlphaGo」もディープラーニングを用いています。AlphaGoはそのメカニズムは過去のプロ棋士同士の対局中に現れた膨大な石の配置パターンを読み込むことで、その場面における自分が有利か不利かを判断しています。

AlphaGoを開発したイギリスのDeepMind社は更に2017年10月、囲碁ルールのみを与えた「AlphaGo Zero」が40日という短期間で、従来のAlphaGoのどのバージョンよりも強くなったことを発表しました。AlphaGo Zeroで用いられた手法は「強化学習」というものです。強化学習では、研究者は人工知能に過去の対局記録や正しい手筋を教えません。そのかわりに、人工知能同士で対局を行わせ、より多く勝てる打ち筋に「報酬」を与えます。人工知能が自ら、より多くの報酬を得られる、つまりより多く勝てるように試行錯誤して最適な打ち筋を学習していくのです。過去データを用いることなく強くなったことを示すこの結果は、もはや人工知能が人類の手をはなれて進化し続けることを示唆しているといえるかもしれません。

未来を見通すことも可能になりつつある人工知能

・これまでのディープラーニングは主に、静止画像のような「静的な(時間の流れをともなわない)」情報に対して用いられてきました。しかし、動画のように先の展開を予測する必要がある情報の場合、従来のディープラーニングを用いることはできません。

そこで最近、注目を集めている技術が「リカレント・ニューラルネットワーク(RNN)」です。「リカレント」とは「循環する」という意味で、今の時刻の情報を処理する際に、少し前の時刻の情報と統合したうえで処理し、出力することを意味します。少し前の自分の状態に学ぶしくみだということもできます。

私たちは、時々刻々と変化する風景をとらえ、物体の動きを予測し、次の行動を決定します。たとえば正面からボールが飛んできた場合、私たちは反射的によけることが可能です。しかし現在の人工知能は、このような当たり前の予測を行うことができません。なぜなら、ボールが動く映像の実体は、静止画を1枚1枚コマ送りしたものにすぎず、それぞれの静止画のつながりを理解することはむずかしいためです。人工知能にとって「時間」を理解することは困難なのです。

私たちの脳内では、ボールの視覚情報が一次視覚野から二次視覚野、そして高次視覚野へと伝えられる一方で、高次視覚野から一次視覚野へと“逆流”する信号もあるといいます。これは、先に伝わった情報と後から来た情報を統合することで、物体の動きを補正し、正確にとらえるためだと考えられています。この“情報の逆流”を人工知能に搭載した技術がRNNであるといえます。

2 人工知能の最新応用技術

●人工知能の進化

人工知能が動作や言葉を理解し、社会に進出していく

・人工知能は新しい能力を獲得するたびに、人工知能が活躍する領域は広がっていくと考えられます。特に、動作に関連する概念は、ロボットが人間社会で実現に行動するためには必須の能力だといえます。

能力1.画像を正確に見分けられる

能力2.複数の感覚データを使って特徴をつかむ

・今後は人工知能も、視覚情報に温度や音などの情報も組み合わせて、抽象的な概念を理解できるようになります。

能力3.動作に関する概念を獲得する

・「ドアを開ける」といった、自分の動作(例えばドアを押す)とそれがもたらす結果(ドアが奥に開く)を組み合わせた概念です。これらの動作の概念がないと、ロボットは行動計画を立てることができません。

能力4.行動に通じた抽象的な概念を獲得する

・例えば、ガラスのコップは硬いといった抽象的な概念(感覚)は、さまざまな材質のコップを実際に触ったり、落として壊したりすることで獲得できます。こういった感覚は、人間とともに暮らして家事や介護を行うロボットには必須です。

能力5.言葉を理解する

・音声認識や自動翻訳などの言語に関する能力はかなり進んでいますが、まだ人間と同じように言葉を理解しているわけではありません。

能力6.知識や常識を獲得する

・言葉が理解できると、人工知能はインターネット上の情報などから知識や常識を獲得することができるようになります。

3 人工知能の未来

●汎用人工知能①~②

汎用人工知能では、脳をまねてモジュールをつなぎ合わせる

・今の人工知能は、ディープラーニングなどのニューラルネットワークを使用した「モジュール」(プログラムの構成単位)をいくつか組み合わせることでできています。現在は、人間が特定の問題に応じてモジュールを組み合わせて人工知能を設計しています。つまり、その問題しか解けない設計になっています。それに対して、全能アーキテクチャが目指す「汎用人工知能」は、私たちの脳が普段から行っているように、必要に応じて複数のモジュールを自動的に組み合わせることを目指しています。臨機応変に自分自身の設計(プログラム)を変えることで、さまざまな問題を柔軟に解決できるようになります。

・現在の開発状況から見て、人間と同程度の能力をもつ汎用人工知能は2030年頃に完成するのではないかという声が出ています。

大脳基底核や大脳皮質のほか、運動に関わる小脳に相当する人工知能の開発は比較的進んでいますが、海馬に相当するものや、それらを統合するための人工知能の開発は遅れています。

未知の状況に対応する能力をもつ汎用人工知能は、自律的な行動が求められる「災害救助ロボット」や「惑星探査機」などに応用されることが期待されています。

・モジュールは、脳の各部位や領野に対応するプログラムです。全脳アーキテクチャでは、各モジュールを必要に応じてさらに細かい機能に分類して、それらを統合することで、人間の脳と同じような機能を実現する汎用人工知能を目指しています。

●シンギュラリティ

シンギュラリティの到来時期は賛否両論

・「シンギュラリティ(singularity)」は技術的特異点と訳される。人工知能が自分自身で猛烈な進化を続けると、人間の知能を追い抜き、遂には人類がその先の変化を見通せない段階まで進化するという説があります。これはアメリカの人工知能研究者であるレイ・カーツワイル博士が2005年に発表した著書『シンギュラリティは近い』によって世界に知られるようになりました。

・あと数十年でシンギュラリティがやってくるという説には否定的な意見は少なくありません。しかしながら、時期は分かりませんが人工知能がこのまま進化することで、あらゆる分野で人間の知能を上回る時代がいずれやってくることについては、人工知能研究者の多くが同意しているようです。

4 人工知能の新領域へ

●インタビュー 平野 晋博士

AIに常識や倫理観、感情は必要か

『AIネットワーク社会推進会議で取りまとめられた「国際的な議論のためのAI開発ガイドライン案」。AIの著しい発展を受け、近い将来、社会にAIネットワークが構築されることを前提として検討された九つの開発原則である。ただし、このガイドライン案はあくまで指針案であり、法的な拘束力はない。』

感想

『人工知能は新しい能力を獲得するたびに、人工知能が活躍する領域は広がっていくと考えられます』これが全てのように思います。

過熱状態は落ち着き、浮き沈みはあるでしょうが、生成AIはクラウドに匹敵するようなITを長期的に牽引する革新になるだろう思います。

開発環境あるいは開発支援のサービスも充実してきています。AIをリードしているNVIDIAといえばGPUという汎用型のAIアクセラレーターで有名ですが、各ニーズに対応した特化型のAIアクセラレーターも登場しています。CPUの両雄(IntelとAMD)も動いているようです。特にAMDは2023年6月にMI300Xという汎用型GPU(GPGPU)を発表しました。Big TechのMetaも、Google、Amazonに続きAI用の独自チップの開発を発表しました。さらに、テスラは独自に設計したチップとインフラストラクチャを使用したカスタムスーパーコンピューター“Dojo”を発表しました。

ソフトウェア、ハードウェアの進歩は止まることはありません。世界中の研究者によって新しい技術が“今”を変えていきます。そして、人工知能のニーズは医療、介護、小売、運輸、災害支援、宇宙開発など多岐に渡ります。

仮想空間はアバターを利用してネット上で交流する“メタバース”に進化しました。通信では5Gに続く、“Beyond5G(6G)”は2030年頃と目されているようです。

シンギュラリティが本当にやってくるのか、それはいつか、不安もありますが、おそらく人類の進歩の歴史の中で、それは避けられないのではないかと思いました。

画像出展:「Yahooニュース」

米議会は9月13日、テスラのイーロン・マスクCEOのほか、メタ・プラットフォームズのマーク・ザッカーバーグCEO、アルファベットのスンダー・ピチャイCEOらテクノロジー業界の幹部を招き、人工知能(AI)に関するフォーラムを開催した。写真は、米議会で開かれたAIフォーラム(2023年 ロイター/Leah Millis)

『上院民主党トップのシューマー院内総務はフォーラムの冒頭「超党派のAI政策の基盤を整備するという巨大で複雑、かつ重要な取り組みをきょう開始する」と表明。「議会が役割を果たさなければ、AIの恩恵を最大化することも、AIのリスクを最小化することもできない」と述べた。

また、とりわけディープフェイクについては優先的に対応し、2024年の選挙前に規制する必要性があると強調した。

フォーラムは非公開で開催。60人を超える上院議員のほか、エヌビディアのジェンスン・ファンCEO、マイクロソフトのサティア・ナデラCEO、IBMのアービンド・クリシュナCEO、マイクロソフト創業者のビル・ゲイツ氏らも参加した。』

ご参考:“テスラが開発中のロボット(Optimus)の動画”

ティム・クックのApple

多くの人がそう思っていたのではないでしょうか。スティーブ・ジョブズを失ったアップルの将来は厳しいだろうと。ところが実際にはそうはならず、アップルはより大きな企業になりました。その立役者はCEOのティム・クックです。

「どんな人物なんだろうか?」、「スティーブ・ジョブズとティム・クックを結びつけたのは何だったのだろうか?」。特に後者は最も知りたい“謎”でした。

また、スティーブ・ジョブズの自伝にあった“こだわり”も気になりました。この点からも、何故、ジョブズはティム・クックだったのか知りたいと思いました。

画像出展:「スティーブ・ジョブズⅡ」

『僕は、いつまでも続く会社を作ることに情熱を燃やしてきた。すごい製品を作りたいと社員が猛烈にがんばる会社を。それ以外はすべて副次的だ。もちろん、利益を上げるのもすごいことだよ。利益があればこそ、すごい製品は作っていられるのだから。でも、原動力は製品であって利益じゃない。スカリーはこれをひっくり返して、金儲けを目的にしてしまった。ほとんど違わないというくらいの小さな違いだけど、これがすべてを変えてしまうんだ―誰を雇うのか、誰を昇進させるのか、会議でなにを話し合うのか、などをね。』[スティーブ・ジョブズⅡp424](上記のメッセージはブログの2.「最後にもうひとつ……」の先頭に出ています)

ブログは目次に続き各章のごく一部をご紹介していますが(黒字)、これ以外に印象的だったクックの成果として、[慈善活動に対する積極的な取り組み]、[再生可能エネルギーへの移行]など、スティーブ・ジョブズの時代には、消極的だったこれらの課題に対しても素晴らしい成果をあげられていました。

目次

序論 うまくやってのける

第1章 スティーブ・ジョブズの死

クックは取るに足りない人物

ジョブズが辞任し、クックがCEOに

スティーブ・ジョブズの死

スティーブ・ジョブズの会社を経営する

破滅する運命のアップル

第2章 アメリカの深南部で形作られた世界観

スウィートホーム・アラバマ

学生時代

早期のビジネス経験

ロバーツデールがクックの世界観を築いた

アラバマ行動主義のルーツ

故郷のアンチヒーロー

オーバーンで工学を学ぶ

第3章 ビッグブルーで業界を学ぶ

IBM PC

リサーチ・トライアングル・パークの工場

ジャストインタイム生産方式

クックの初めての仕事

クックの高い潜在能力

クックのMBA

早期の倫理規範

IBMのソーシャルライフ

IBMでの昇進

インテリジェント・エレクトロニクスに転職する

コンパックに合流する

第4章 倒産寸前の企業に加わる、一生に一度の機会

意見の一致:クック、ジョブズに出会う

オペレーションの新たなリーダー

さよなら、アメリカ。こんにちは、中国!

第5章 アウトソーシングでアップルを救う

フォックスコン

とんとん拍子に出世する

マネージャーとしてのクック

第6章 スティーブ・ジョブズの後を引き継ぐ

ピノキオ並みの硬さ

初期の挫折

採用と解雇

アップルは全盛期を過ぎたのか

クックはアップルの変革を始める

サプライチェーンにおける取り組み

成功の兆し

第7章 魅力的な新製品に自信をもつ

脱税

MacProとiOS7

iPhone 5Sが記録を打ち立てる

良い年末

世界開発者会議―iOS8と健康部門への参入

アンジェラ・アーレンツティム・クックのティム・クック

驚くべきパートナーシップ

IBMとのパートナーシップ―法人向けiOS

iPhone 6とApple Pay

iOS 8.0.1の厄介なバグ

Apple Pay

クックの初の主要製品:Apple Watch

第8章 より環境に優しいアップル

汚染と中毒

良い方向へ進む

ダーティな仕事に取りかかる

環境保護庁の門をたたく

善行を促進する力

クックは太陽光発電に力を注ぐ

クローズドループのサプライチェーン

持続可能な森林

ひたむきなCEO

第9章 クックは法と闘い、勝利する

プライバシーの問題

サンバーナーディーノ

長期にわたる論争

抗議の嵐

作戦指令室

アメリカにパライバシーは存在しない

訴えを取り下げる

クックはプライバシーを強化する

第10章 多様性に賭ける

パーソン・オブ・ザ・イヤー

平等と多様性はビジネスの役に立つ

多様性による革新

女性を昇進させる

アップルの組織構成

株主からのプレッシャー

教育におけるクックの取り組み

早いうちに種をまく

アクセシビリティ

第11章 ロボットカーとアップルの未来

未来の取り組み

アップル・パーク

キャンパスがオープンした日

すべてが成功したわけではない

協調を促す

うまくいっているようだ

次世代iPone、Xの到来

第12章 アップル史上最高のCEO?

クックは革新できるのか?

革新には時間がかかる

教訓を得る

第1章 スティーブ・ジョブズの死

破滅する運命のアップル

・2014年9月:チャーリー・ローズ[ニュースキャスター]とのインタビュー

『クックはジョブズが残したものを何とかして維持し、自分の持つすべてを会社に注ぎ込むことを望んでいた。しかし、ジョブズの真似をしようと考えたことはなかった。「自分がなれるのは、自分自身だけだということを理解しています」と彼は続けた。「私は最高のティム・クックになるように努力しているのです」そして、これこそが、彼の成し遂げたことだった。

第2章 アメリカの深南部で形作られた世界観

学生時代

・ロバーツデールは典型的な南部アメリカの田舎町。面積はわずか13平方キロメートル。当時の人口は約2300人(現在は約5000人)。

・クック家は信仰に篤く、クリスチャンである。

・幼い頃に、バプテスト教会で洗礼を受けてから、信仰は人生の大きな部分を占めてきた。

・クックは控えめで向上心が高く、常に成績優秀な生徒だった。知的で穏やかな性格でユーモアのセンスもあった。

・『彼がアップルで実践した価値観の多くは、子どもの頃に経験した差別と直接結びついているようだ。2013年、デューク大学フュークア・スクール・オブ・ビジネス(クックはここで修士号を取得している)で行われた学生向けの講演会で、クックは、キング牧師とケネディ大統領の2人が子どもの頃からのヒーローだと語っている。「私は南部で生まれ育ち、成長の過程で、差別が引き金となった最悪の行動の数々を目にし、非常に気に病む思いをしてきました」と、彼は学生たちに語った。だからこそ、命がけで差別と戦ったキングとケネディを、心から尊敬しているのだろう。』

オーバーンで工学を学ぶ

・『「アラバマ大は医師や弁護士を志望する富裕層が行くところだったので、自分を労働者階級の1人だととらえていた私には適さないと思いました。そして労働者階級の人々は、オーバーンへ行っていたのです」』

・クックが学んだ生産工学は、複雑なシステムを最適化する方法に焦点を置き、無駄な支出を取り払い、資源を最大限活用する最善策を見つけ出す学問であった。

・クックは2010年、オーバーン大学の卒業式のスピーチで、オーバーン大学の理念を自分の信念として話しているが、それは次のようなものである。『「私はここが、実践的な世界であると信じており、ゆえに、自分が培ったもののみが信頼に値すると考えている。したがって私は、働くこと、ひときわ懸命に働くことの価値を信じる。私は、正直であることと、誠実であることの価値を信じる。それなしでは、仲間の尊敬と信頼を勝ち取ることはできない」。』

・クックは1982年にオーバーン大学を卒業、アンダーセンコンサルティング(現アクセンチュア)とゼネラル・エレクトリックからもオファーを受けていたが、IBMに入社(PC部門)した。

画像出展:「WikipediA」

アラバマ州ロバーツデールは、2010年の国勢調査では人口5,276人、1,951世帯だったそうです。

第3章 ビッグブルーで業界を学ぶ

クックの高い潜在能力

・IBM入社数年後、クックは工場の経営幹部によって選ばれる「ハイポ(ハイ・ポテンシャル)」と呼ばれる将来を担う25名の若手社員リストのランキング1位にいた。なお、「ハイポ」に求められるものは、業績、責任感、リーダーとしての潜在能力など。

・『クックがハイポ・リストの一角を獲得し、最終的にはIBMでの高い地位[パーソナル・コンピューター事業北米ディレクター]を確立するまでになったのは、高校と大学を通して彼が培った労働倫理のおかげだった。工場におけるパーソナル・コンピューター製造の元責任者で、かつてクックの上司だったこともあるレイ・メイズも、クックが同僚たちの中で抜きんでていたことに同意している。「私が感じていた彼の優れたところは、その労働倫理でした」とメイズは語った。』

早期の倫理規範

・ビジネスで“倫理”というと、不正会計やインサイダー取引を連想するものだが、クックの“倫理”はそのようなものではない。

・『2013年、デューク大学で行われた同窓会[デューク大学のFuqua School of Businessを1988年に卒業]で、クックはこのように語った。

「倫理について考えるとき、私はある物事を、それを発見したときよりも良い状態で、後に残すことを考えます。そしてこのことは私にとって、環境への配慮から、労働問題を抱えるサプライヤーとの付き合い方、製品の二酸化炭素排出量、何を支援するかという選択、そして従業員の扱い方まで、すべてに関わることなのです。私のすべての言動は、この考え方がもとにあるのです」。

倫理学の講義によって、彼は同じ業界の人の多くとは異なる方法でビジネスを考えるようになった。彼がそこで学んだ教訓 ―発見したときよりも良い状態で、物事を後に残すこと。環境に配慮し、従業員に敬意をもって接すること― は、彼の信念の支えとなり、アップルCEOとしての任期を象徴するものとなるだろう。彼はIBMで、アップルにおけるリーダーシップの基礎となるものを築き始め、そこには同僚との交流も含まれていた。』

画像出展:「江戸切子協同組合」

私事ですが、早大サッカー部時代に「伝統とは、前年をひとつでも上回る成果を上げ、積み重ねていくこと」と教わったことを思い出しました。

この日本流の“伝統”は、クックの信念の支えとなった“倫理”とスティーブ・ジョブズが願っていた、“いつまでも続く会社”につながるキーワードではないか、ジョブズとクックを結んだ最も重要な価値観だったのではないかと思いました。

つまり、私が最も知りたかった“謎(二人を結んだもの)”とは、“伝統を重んじる心”だったというのが私なりの答えです。

第4章 倒産寸前の企業に加わる、一生に一度の機会

意見の一致:クック、ジョブズに出会う

・『ティム・クックは、アップルのリクルーターからオファーをすでに何度も断っていた。彼らの粘り強さが実を結ぶときがきた。最終的に、彼は少なくともジョブズには会うべきだという結論に達したのだ。「スティーブは、私がいる業界のすべてを作った人物でした。とても会ってみたかったのです。クックは2014年、チャーリー・ローズに対してこう暴露している。

彼はコンパックでの仕事に満足していたが、ジョブズとの出会いは新鮮でエキサイティングな将来の展望を彼に与えてくれた。ジョブズは「他の人とは全く異なることをしていました」とクックは当時を振り返った。その最初の面接で、ジョブズのアップルに対する戦略とビジョンを座って聞いていたとき、彼はそのミッションにおいて自分が価値ある貢献をできるということに納得した。ジョブズはコンピューター業界を震撼させることになるだろう製品や、いまだかつてないコンピューターのデザインコンセプトについて説明した。これらの構想は、丸くふくらんだ形のカラフルなMacintoshであるiMac G3となって、1998年に発売され大成功をおさめ、デザイナーであるジョニー・アイブを一躍有名にした。

クックは好奇心をそそられていた。「彼はそのデザインについてほんの少ししか話しませんでしたが、それだけで十分、私は関心を持ちました。後のiMacとなる製品について説明してくれたのです」。クックはその面接が終わる頃には、ジョブズのようなシリコンバレーの伝説と働くことは、一生ものの栄誉」になることを確信していた。』

第5章 アウトソーシングでアップルを救う

とんとん拍子に出世する

・入社4年後の2002年に、ワールドワイドセールスならびにオペレーション担当副社長になった。

・2004年にはMacintoshのハードウェア部門の責任者になり、2005年にはCOOに任命された。

・COOの昇進を機に、ジョブズはクックを自らの後継者として育て上げていった。アップルに勤めるすべての社員はスペシャリストだが、ジョブズとクックだけは違っていた。

マネージャーとしてのクック

・ジョブズとクックは何年もの間緊密に協力しながら働いてきたが、立ち振る舞い、気質、特にマネジメントは全く違っていた。

・『彼が声を荒げることはほとんどなかったが、問題の核心に迫ることに執着し、質問を延々と投げかけて人々を疲弊させた。「彼はとても静かなリーダーです」とジョズウィアックは語った。「叫ぶことも怒鳴ることもなく、非常に冷静で落ち着いています。しかしとにかく人を質問攻めにするので、部下たちは問題についてしっかりと把握しておく必要があるのです」。質問をすることで、クックは問題を掘り下げることができ、スタッフに自分がしていることを常に把握し、責任感を感じさせる効果があった。彼らはいつでも説明を求められる状況にあることを理解していた。

1998年12月に、クックのオペレーション担当グループに参加したスティーブ・ドイルは次のように語った。「彼は10の質問をしてきます。それらに正しく答えると、さらに10の質問をしてきます。それを1年経験すると、彼の質問は9つに減ります。しかし1つ間違えれば、質問は20、30と増えていくのです」。』

・クックは日曜日の夜に電話会議を受け、午前3時45分にメールの返信を行い、毎朝午前6時までには自分のデスクについていた。そしてオフィスで12~13時間働き、家に帰ってからはもっと多くのメールに返信した。

・クックは中国に行き、16時間の時差をものともせずに3日間働き、午前7時にアメリカに戻り、8時30分からの会議に出席することは珍しいことではなかった。

・オフィスにいない時のリラックス方法は、ジムに出かけるかロッククライミングをすること。また、熱心なサイクリストであり、土日はよく自転車に乗っているため、そのときだけは同僚はメールを気にせずにすんだ。

・クックは自分の健康状態を非常に気にかけていて、混雑する時間帯を避けるため、他の人より早起きしてジムに行っている。

・『彼は仕事とスポーツを同等のものと見なして次のように語っていた。「ビジネスにおいては、スポーツと同様に、勝利のほとんどはゲームの開始前に決定されているのです。我々は、好機がやってくるタイミングを整えることはできませんが、準備を整えておくことはできるのです」。クックの準備へのこだわりは、アップルにおける彼の成功の鍵である。』

・クックの最初の12年間のキャリアは比較的目立たないものだったが、クックは匿名でいることを重要視し、アップルの秘密のカーテンの後ろに隠れたままでいた。

第6章 スティーブ・ジョブズの後を引き継ぐ

成功の兆し

・2012年12月、クックは「タイム」誌の“世界で最も影響力のある100人」に選ばれたが、この記事の中で、アップルの元副社長で、2003年からは取締役を務めていたアル・ゴア[ビル・クリントン大統領時代の副大統領]は、クックに関して次のように記している。

『「伝説的存在であるスティーブ・ジョブズの後を継いで、アップルのCEOになること以上に難しい挑戦を私は知らない。しかし、アラバマ造船所の労働者と主婦の間に生まれ、穏やかで謙虚、物静かだが熱心な性格のティム・クックは、少しも動じることがなかった。ジョブズの残したものを守り抜き、アップルの文化に深く浸っている51歳のクックは、主要な方針転換を円滑かつ見事に実施しながら、世界で最も価値ある革新的な企業を、さらなる高みへと導くことに成功した。彼は、その複雑な社内構造の管理から、新たな「とてつもなく素晴らしい」テクノロジーおよびデザインの飛躍的進歩を製品パイプラインに落とし込むことまで、アップルのあらゆる分野において、自らのリーダーシップを強く発揮している」。』

第7章 魅力的な新製品に自信をもつ

世界開発者会議―iOS8と健康部門への参入

・2014年の世界開発者会議(WWDC)で新しいiOS8の発表に加え、HealthKitと組み合わせた健康管理アプリによって、1兆ドル規模のヘルスケア業界(健康とウェルネス分野)への参入を発表した。

画像出展:「biotaware」

”Apple ResearchKit, HealthKit and CareKit, Health App – what does it all mean?”

英語のサイトですが、Googl翻訳に助けて頂き、それぞれの概要をお伝えします。

◆HealthKit(アイコンは左端)

HealthKitは、ヘルスケアアプリとフィットネスアプリを格納するために設計されたフレームワークであり、それらを一緒に使用してデータをすべて1か所で照合できます。

◆ResearchKit(アイコンは左から2番目)

ResearchKitは、医学研究専用に設計されたオープンソースソフトウェアフレームワークです。ResearchKitを使用すると、医学研究者はアプリを迅速かつ最終的に開発し、このフレームワークから開発されたアプリを通じて有意義で価値のあるデータを取得できます。

◆CareKit(アイコンは右端)

CareKitは新しいソフトウェアフレームワーク(2016年4月にリリース)であり、これにより、開発者は、医療を追跡して管理する医学に特化したアプリを構築できます。作成されたアプリは、患者が自分の病状をよりよく理解して自己管理できるようにすることを目的としています。これは、たとえば、服用した薬の効果を追跡するのに役立ちます。

クリック頂くと株式会社C2さまの”ResearchKit/CareKit”のサイトに移動します。

『C2では、ResearchKitアプリおよびCareKitアプリの開発をお手伝いします。企画、要件定義、画面設計、開発 (アプリ&サーバ)、Appストア配信までをワンストップでサポートいたします。』

なお、事例として、京都大学さま、順天堂大学さま、国立がん研究センターさま等が紹介されています。

クックの初の主要製品:Apple Watch

・『アップルの幹部たちは、ジョブズの死から数週間後、ブレーンストーミングを始めた。つまりこの時計のアイデアは、スティーブの死から間接的に生まれたものだと言うことができる。「最初のディスカッションは、スティーブが亡くなった数カ月後2012年初めに行われました」とアイブは語った。「それには時間がかかりました。我々がどこに行こうとしていたのか、企業としてどんな軌道に乗っていたのか、そして何が我々のモチベーションとなっていたのかを、皆でじっくりと考えたのです」。そうして生まれたのがApple Watchだった。』

・これをみてスティーブ・ジョブズの伝記に書かれていた文章を思い出しました。

画像出展:「homestead」

『僕が病気になってある意味良かったと言えることは少ないけど、そのひとつが、リードが優れた医師とじっくりいろいろな研究をするようになったことだ。21世紀のイノベーションは、生物学[biology]とテクノロジーの交差点で生まれるんじゃないかと思う。僕が息子くらいのころデジタル時代がはじまったように、いま、新しい時代がはじまろうとしているんだ」』

第8章 より環境に優しいアップル

クローズドループのサプライチェーン

・2016年3月、アップルはiPhone6を分解するリアム(Liam)というロボットを発表し、クローズドループのサプライチェーン(製品の製造をリサイクルされた原料のみで行うこと)に向けた大きな一歩を歩み出した。現在、2機のリアムはアメリカとオランダに1機ずつあり、11秒ごとにiPhoneを完全に分解している。

第9章 クックは法と闘い、勝利する

クックはプライバシーを強化する

・2018年4月に発表されたiOS11.3はプライバシー保護に強化を加えているが、このアップデートには、ユーザーの個人データがアップルのサービスによって収集されていることを明確に示すアイコンが追加された。アップルが個人情報を収集するのは、機能を有効にする必要があるときや、サービスを保護するとき、またはユーザー体験をパーソナライズする必要があるときだけである。

・アップデートしたユーザーへの通知は次のような説明がされていた。『「アップルはプライバシーを基本的人権だと考えているため、すべてのアップル製品はデータの収集と使用を最小限に抑え、可能な限りデバイス上で処理し、お客様の情報に対する透明性と管理を提供するよう設計されています」。』

第10章 多様性に賭ける

・クックは同性愛者である。この表明は2014年10月30日、ブルームバーグに掲載された「ティム・クックは語る」という感動的なエッセイの中で行われた。また、表明した理由など心に残るメッセージがある。

・『「私は自分自身がゲイであるおかげで、マイノリティであることの意味をより深く理解することができ、他のマイノリティグループに属する人々が日々直面している課題についても考えることができるようになったのです」。』

・『CBSの「ザ・レイト・ショー」に出演したクックは、自分がアメリカのセクシャアル・マイノリティの若者たちを助けることができると気づいてから、自らのセクシャリティを公表することを決めたと語った。「子どもたちは学校でいじめられ、その多くは差別され、両親から拒絶されています。私が何とかしなければならないと感じたのです」と彼は語った。「私は自分のプライバシーを非常に重視していましたが、他の人のために何かすることのほうが、それよりもはるかに重要と感じたのです。皆さんに私の真実を伝えたいと思いました」。』

第11章 ロボットカーとアップルの未来

未来の取り組み

・タイタンと呼ばれるプロジェクトは、Apple Carという自動運転車に関するもので2014年にクックが承認したプロジェクトである。そのきっかけはジョブズが、当時大きな話題となっていた、テスラモーターズの新たな電気自動車に興味をもった2008年にさかのぼる。(ジョブズは当時の自動車業界の状況から自動運転車を追及しない決断をくだしている)

・『2017年6月、クックはプロジェクト・タイタンについて初めて公に語り、ブルームバーグに対し、「自動運転システムに焦点を合わせている」ことを認めた。「これは、我々が非常に重要視する核となるテクノロジーです」。そしてクックはこう付け加えた。「我々は、これをすべてのAIプロジェクトの母であると考えています。おそらく現存するAIプロジェクトの中で、最も難しいものの1つです」。』

・タイタンの問題は製品開発だけでなく、雇用やマネジメント、そしておそらくビジョンにおいても失敗していると評価されており、軌道に乗っているのかいないのかさえ明らかになっていない。

Appleが自動運転車を開発していることは全く知らず、大変驚きました。しかし、その”タイタン”と呼ばれているプロジェクトは苦戦していることを知りました。

そこでネット検索してみると、【Patently Apple】という、Appleの知的財産(IP)や最新のニュースを発信するブログ(英語)があり、”タイタン”に関しても色々なニュースが掲載されているのを知りました。

第12章 アップル史上最高のCEO?

革新には時間がかかる

・クックのもとで発売された最初の新ジャンルの製品であるApple Watchは、当初は不信感をもって迎いられ、一笑に付されることもあり、初期の評価は面白いおもちゃではあるが、世界を変える製品ではないというものあった。しかし3年後、Apple Watchはスマートウォッチ市場で最大の勢力となり、スイスの時計業界全体よりも大規模となっていた。

・Apple Watchは、アップルの健康とウェルネスに対する熱意を形にしたプラットフォームであり、HealthKitやResearchKitのようなソフトウェアによって、着用者が自分の健康とフィットネスをモニターし、改善するのをサポートする手首装着型コンピューターの基礎を築いている。

こちらは、”お茶の水循環器内科さま”のサイトです。2020年9月7日に「アップルウォッチ外来」を開始されたとのことです。

『お茶の水循環器内科ではアップルの「家庭用心電計プログラム」「家庭用心拍数モニタプログラム」が医療機器承認を受けて、アップルウォッチ外来を開始しました。具体的には、不整脈の発作時の記録をもとに、不整脈の疑いの評価、さらなる精密検査の必要性、治療の必要性等を相談するものです。』

付記

《「スティーブ・ジョブズとティム・クックを結びつけたのは何だったのだろうか?」。特に後者は最も知りたい“謎”でした。》

この疑問に対する自分なりの答えは以下のようなものでした。

《この日本流の“伝統”は、クックの信念の支えとなった“倫理”とスティーブ・ジョブズが願っていた、“いつまでも続く会社”につながるキーワードではないか、ジョブズとクックを結んだ最も重要な価値観だったのではないかと思います。つまり、私が最も知りたかった“謎(二人を結んだもの)”とは、“伝統を重んじる心”だったというのが私なりの答えです。》

読み終わってみて、ジョブズとクックを結んだのは、もう一つ、幼少期の体験を通して”研ぎ澄まされた精神が潜在的に共鳴した”からではないかと思います。

労働階級の家に育ち、両親からの愛情に心をよせ、加えてジョブズは養子をバネに、一方クックは差別の多い南部の田舎町に住み、自分自身がセクシャルマイノリティであったことをバネに、強い気持ちや揺るぎない信念(ジョブズは父親譲りの完璧な物づくり、クックは確固たる倫理感)を醸成したのだと思います。

量子コンピューター誕生

【量子超越】(quantum supremacy)というのは、「量子コンピューターで従来のコンピューターにはできない計算をする」という意味の造語だそうです。

量子コンピューターが世界最速のスパコン(スーパーコンピュータ)を凌駕したという【量子超越】のニュースは、前々回のブログ“スマート・クリエイティブ”の中でご紹介しましたが、このGoogle の量子コンピューターのことは、日経サイエンスで特集されていました。

日経サイエンス 2020年2月号

出版:日経サイエンス

発行:2020年2月

量子コンピューターはたった53個の素子で世界最速のスパコンを超える計算を実行した。この計算能力を生かせるキラーアプリケーションの発見を目指して世界中で競争が始まっている。

画像出展:「日経サイエンス」

「前」世界最速のスパコン

米国立オークリッジ研究所にあるスパコン

サミット

・台数(ノード数):4608

・CPU数:9216

・メモリ:10PB(ペタバイト)

・ストレージ:250PB

・OS:Linux

2020年6月22日に富士通/理化学研究所の“富岳”が世界1位になったという発表がありました。

画像出展:「日本経済新聞」

性能比較

Google 社の量子コンピューター(53個の超電導量子ビット)

画像出展:「日経サイエンス」

チップの中身

量子コンピューターチップには、53個の超電導量子ビット(右)が格子状に並び、接続を制御する接続器でつながっている。1つ抜けているのは(上段中央の白いチップ)壊れて動作しなかったため。

この特集は技術的な解説が中心ですが、難解ということもあり、私の関心は“これからの見通し”と“量子コンピューターの扉を開けたのは誰か”という2点です。

前者は、「量子コンピューターが近い将来に世界を変えることはない。これは現在の量子コンピューターが計算できるのは特殊なものに限定されており、科学者や産業界が期待する実用的な計算ができるようになるかどうかは未知数である」ということでした。

東京大学の中村泰信先生は、『「今の延長で、2~3年のうちにおそらく200量子ビット程度まではいけると思う」』、とお話されています。

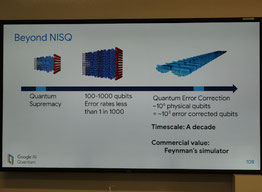

また、本誌には2つの視点から今後の課題が書かれています。

①『各ビットを制御するために必要な膨大な配線をどう処理するかが大規模化の課題になるという。よく巨大なシャンデリアのような量子コンピューターの写真を見かけることがあるが、あれは中心にある量子チップを冷やす冷凍機で、無数の金属線はそのチップの素子を制御する配線だ。』

②『エラーを訂正しながら計算が続けられる量子コンピューターを実現するにはあと20~30年かかると、研究者の多くはみている。それまではエラー耐性量子コンピューターを目指しつつ、エラー訂正できない小規模な量子コンピューター(これをNISQ[Noisy Intermediate-Scale Quantum device]と呼ぶ)で何か面白い計算ができないかを探索する研究が進むだろう。』

量子コンピューターは極めて興味深い技術革新ですが、まだまだツボミ、満開になるまでにはかなりの月日を要するようです。

後者の“誰が量子コンピューターの扉を開けたのか”という疑問は、オックスフォード大学の物理学教授、ディヴィッド・ドイッチュ(David Deutsch)先生というのが答えでした。日経サイエンスの記事の中にも誕生までの経緯に関するお話が出ていましたので、そちらをご紹介します。

・量子的に動作するコンピューターというアイデアが初めて注目を集めたのは1981年5月、IBMの計算機科学者ランダウア―(Rolf Landauer)が主催した「第1回物理と計算の国際会議」である。会議には著名な物理学者のファインマン(Richard Feynman)が招かれ、計算機による物理コミュニケーションについて講演した。そして「(量子力学以前の)古典力学を扱う解析はどれもうまくいかない。自然は古典力学では動いていないので、シミュレートするなら量子力学的にやるべきだ」と結論し、量子コンピューターの必要性を予言した。

・『ドイチュが1985年に量子コンピューターの動作を定式化した論文を出したときには、「反響はほとんどなかった」という。量子的な重さね合わせは今でこそ計算のリソースと捉えられているが、当時は量子力学を構成する理論上の枠組みだと思われていた。そんな実体のないものに情報を保存して計算するというのは突拍子もない話で、しばしば「幽霊を使って計算するコンピューター」と評された。

だが量子コンピューターの理論に関心を持つ人はじわじわと増えていった。1994年にベル研究所のシェア(Peter Shor、現マサチューセッツ工科大学)が量子コンピューターによって巣因数分解を桁違いの高速で解くアルゴリズムを提唱すると状況は一変し、大勢の研究者が流入して、第1次の量子コンピューターブームが起きた。』

※ご参考:量子論および「重さね合わせ」についての簡単な説明は、ブログ“スマート・クリエイティブ”の前半にあります。

・1982年ごろ、英オックスフォード大学のポスドク、ドイッチュ(David Deutsch)は、それまで数カ月にわたって進めてきた計算を終え、ひとつの結論にたどり着いた。今まさに理論を完成しつつある新しい計算機「量子コンピューター」は、まったく新しい計算をする。

『「それは特別な瞬間だった」とドイッチュは振り返る。「量子コンピューターの理論は、新しい計算の理論だとわかった」。

1985年7月、ドイッチュは量子コンピューターの理論を論文として発表し、その中でこう書いた。

「いつの日か量子コンピューターを作ることが技術的に可能になるかもしれない。おそらくは超電導回路の量子で」』

・34年後の2019年10月、グーグルの量子AIグループを率いるマルティニス(John Martinis)らが、超電導回路を使った量子コンピューターで、世界最速のスパコンで1万年かかる実験を200秒で実行したとNature誌に発表した。そしてこの劇的な加速によって「量子超越」が実験的に示されたと宣言した。

・マルティニスはカリフォルニア工科大学で行った講演でこう語った。「量子超越は、ソロバンから最先端のコンピューターまで、あらゆる計算機は同じクラスの計算をするという【拡張チャーチ・チューリングのテーゼ】への反論だ。量子コンピューターは、新しいクラスの計算をするデバイスなのだ」。ドイッチュの予想は30年余りを経て、マルティニスによって現実のものとなった。

※IBM社の反論:”Googleが世界で初めて実証した「量子超越性」にIBMが反論、量子コンピューターはシミュレートできるのか?” こちらはGigazineさまの記事になります。

※Google 社の計画:”米グーグルが量子コンピューターの野心的計画、10年以内に「万能」目指す” こちらは日経XTECHさまの記事になります。

画像出展:「Google Research」

こちらはGoogle Researchにあった”Quantum”というページです。左の絵は”The Question of Quantum Supremacy”につながります。また、”Quantum”のページには次のような説明が出ていました。『A research effort from Google AI that aims to build quantum processors and develop novel quantum algorithms to dramatically accelerate computational tasks for machine learning.』

卓越した才能をもったドイッチュ先生の著書の中に、「無限の始まり」という著名な本があることを知りました。

論外の難しさであるのは間違いなく、ページ数も600ページを超える大作のため買うつもりは全くなかったのですが、幸いにも、図書館に所蔵されていることを見つけました。

パラパラとページをめくっていると、400ページの“時間とは「もつれ」現象である”という見出しに続いて、量子コンピューターに関する記述がありました。ブログではその冒頭の部分をご紹介します。

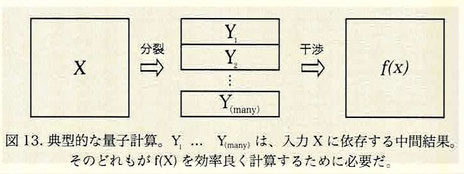

『物理学における私の研究テーマのいくつかは、「量子コンピューター」の理論に関するものだ。量子コンピューターでは情報を伝える変数があの手この手で守られ、周囲ともつれを起こさないようになっている。そうすることで、情報の流れを単一の歴史に限定しない新たな計算モードが実現されている。あるタイプの量子計算では、同時に行われる膨大な数の異なる計算が互いに影響を及ぼし合い、ひいては一つの計算の結果に寄与する。このことは「量子並列性」と呼ばれている。

一般に、量子計算では情報の個々のビットを「キュービット(量子ビット)」と呼ばれる物理的物体で表す。キュービットを物理的に実現する方法はいくつもあるが、二つの不可欠な特徴をかならず備えている。一つは、個々のキュービットに離散的な二つの値のどちらかをとれる変数があること、もう一つは、キュービットをもつれから保護する特殊な措置―キュービットを絶対零度近くまで冷やすなど―が講じられていることだ。量子並列性を用いる典型的なアルゴリズムではまず、キュービットのいくつかで、情報を伝達する変数に両方の値を同時に獲得させる。ここで、キュービットをまとめて(たとえば)数を表す一時記憶(レジスター)と見なせば、レジスターとしてのさまざまな実在の数は、キュービット数の二乗という指数関数的な大きさになる。そして、一時的に古典的な計算が行われ、そのあいだに分化の波がほかのキュービットのいくつかへと広がる―だが、それ以上は広がらない。そうならないような措置が講じられているからだ。ゆえに、情報は膨大な数の自律的な歴史それぞれのなかで別個に処理される。最後に、影響を受けるすべてのキュービットが絡む干渉プロセスによって、数々の歴史に含まれる情報が単一の歴史にまとまる。中間段階の計算が存在し、情報はそこで計算されているため、先ほど議論した単純な干渉実験[多宇宙における情報の流れに関するもの]の場合とは違って、最終状態は初期状態と同じではなく、図13に示すように初期状態の関数となる。

宇宙船の乗組員は自分のドッペルゲンガー[分身]と情報を共有し、一つの関数を異なる入力に対して計算することによって大量の計算をやってのけたが、量子並列性を利用するアルゴリズムでもまさに同じことをする。だが、先ほどの架空の計算は、プロットに合わせていろいろ創作できる宇宙船の規則の制約しか受けなかったのに対し、量子コンピューターは量子干渉をつかさどる物理法則の制約を受ける。多宇宙の助けを借りて実行できるのは、決まったタイプの量子計算しかない。そしてそのタイプでは、最終結果に必要な情報を単一の歴史にまとめるうえで、たまたま量子干渉の数字が最適なのである。

この手法による計算では、わずか数百キュービットの量子コンピューターでも、観測可能な宇宙に存在する原子よりはるかに多い数の計算を並列に実行できる。本書の執筆時点[2011年頃]で製作されている量子コンピューターのキュービット数は10だ。この数の「拡張」は量子テクノロジーにとってたいへん難関だが、徐々に実現しつつある。』

ご参考:”量研(QST)における量子生命科学研究”

上記をクリック頂くと、量子科学技術開発機構さまの資料(PDF19枚)がダウンロードされます。図、写真、表などが多く含まれた親切な資料です。

付記:”量子技術にまい進する中国--第14次5カ年計画にみるその野望”

こちらは、2021年3月30日付のZDJapanさまの記事です。

『~中国はその中でも量子コミュニケーションに対する果敢な取り組みを続けており、さらなる加速に向かってまい進している。中国はその計画の目標の1つとして、古典的な通信テクノロジーに匹敵する長距離高速量子通信システムの開発を挙げている。~』

付記:”IBMが量子コンピューター分野の開発者認定資格をスタート--その背景と意義”

こちらは、2021年4月15日付のZDJapanさまの記事です。

『~この認定資格は、IBMの量子コンピューティング用ソフトウェア開発キット(SDK)である「Qiskit」を利用することにフォーカスしたものだ。QiskitはPythonスクリプトをベースとするオープンソースプラットフォームで、これを利用すれば、量子アルゴリズムの実験から、クラウドベースの量子デバイスでのコードの実行まで、量子コンピューターを使ったさまざまな実験を行うことができる。~』

付記:”グーグル、新たな量子コンピューター研究拠点「Quantum AI」キャンパス披露”

こちらは、2021年5月19日付のZDJapanさまの記事です。

『~Googleが新たに大規模な量子コンピューティング研究センターを開設したことを明らかにした。カリフォルニア州サンタバーバラにあり、数百人のスタッフを雇用する予定だ。このキャンパスには、Googleの最初の量子データセンター、量子ハードウェア研究ラボ、量子プロセッサーチップファブリケーション施設がある。すでに一部の研究者やエンジニアが働いているという。~』

付記:”NVIDIA、日本の量子研究向け ABCI-Q スーパーコンピューターを支援”

こちらは、2024年3月19日付のPRTIMESさまの記事です。

『~産業技術総合研究所 量⼦・AI融合技術ビジネス開発グローバル研究センター 副センター長の堀部雅弘氏は次のように話しています。「ABCI-Q を通じて、日本の研究者は量子コンピューティングについてより深く知り、実用的なアプリケーションのテストおよび開発を加速できるようになるでしょう。NVIDIA CUDA-Q プラットフォームと NVIDIA H100 により、量子コンピューティング研究の新たなフロンティアを探求する科学者を支援します」~』

付記:”NVIDIA、高速化された量子古典コンピューティングのための 新システムを発表”

こちらは、2024年3月21日付のNVIDIA社からの発表です。

『~世界初の GPU アクセラレーテッド量子コンピューティング システムである NVIDIA DGX Quantum は、世界で最も強力なアクセラレーテッド コンピューティング プラットフォーム (NVIDIA Grace Hopper Superchip とCUDA Quantumオープンソース プログラミング モデルによって実現) と、世界で最も先進的な量子制御プラットフォームである Quantum MachinesによるOPX を組み合わせたものです。~』

スマート・クリエイティブ

今回のブログは“Google”に関するものです。「なぜ、Googleに興味をもったのか?」、かなり長い前置きになりますがお付き合いください。

ほとんど関心のなかった自動運転ですが、たまたま入ってきた情報に反応してしまいました。それはグーグルが自動運転で他社を圧倒しているというものです。てっきり、今も五十歩百歩、横一線なのではないかと思っていたため、このニュースに意表を突かれた感じです。

検索してみると、素晴らしいサイトがありました。以下はそのサイトにあった2019年4月1日付の記事です。動画もあり、非常に詳しい紹介がされています。

画像出展:「NEWS CARAVAN」

Google傘下のWaymo、商用自動運転車を目指した10年の軌跡。

『2018年に初めて自動運転を使った配車サービスを商用展開したのがWaymoです。Googleの親会社のアルファベットの傘下でWaymoは、前身のGoogle自動運転プロジェクトから10年もの歳月をかけてようやく、その技術を実用化させつつあります。』

以下のグラフはワシントンポストのニュースにあったものです。“Rates of intervention”という見出しなので、自動運転技術の性能に関するものということだと思います。これを見るとGoogle は競合他社より2桁~3桁、精度が高そうです。

画像出展:「ワシントンポスト」

上記のグラフではTeslaが0になっていますが、下のグラフの補足を見ると、Teslaは公道での実験データを公表していないようです。また、公道でのテストデータに関してもGoogle の実績(距離)は他社を圧倒しています。

画像出展:「OFFICE31051」

ところで、ご紹介した“NEWS CARAVAN”は、“世界中の最新のテクノロジーを扱ったニュースを配信するサイトです”とのことです。その内容は、FAANG(Facebook、Apple、Amazon、Netflix、Googleの頭文字)、AI、Maas/自動運転、サブスクリプションビジネス、IoT、ブロックチェーン・仮想通貨、フィンテック(Finance+Technology)、クラウド、フードテック(Food+Technology)、宇宙開発 の情報を扱っています。素晴らしい完成度です。

そういえば、Googleは量子コンピュータでもIBMと競っていたのを思い出しました。ということで、こちらも検索してみると驚きのニュースが見つかりました。

画像出展:「CNET Japan」

グーグルの「量子超越性」は革命の始まりにすぎない

『1981年に有名な物理学者、故Richard Feynman氏が言及し、Googleが13年間取り組んできた量子コンピューティングというアイデアが、現実に向かって動き出しているのである。』

下の記事はNewsweekのものです。

画像出展:「Newsweek」

『グーグルの研究チームは、同社の量子コンピューターが、従来のスーパーコンピューター(スパコン)で約1万年かかる計算を「わずか数分」で解いたと発表した。』

『量子コンピューターは、量子力学の奇妙な原理を利用して計算を行う。従来型のコンピューターは「ビット」という情報単位を使っている。これは「0」か「1」のどちらかの状態しか表すことができないのに対し、量子コンピューターが使う情報単位「量子ビット」は、同時に「0」でも「1」でもあって、「0」と「1」の間のすべての値でもある。扱える情報量が大幅に増えるため、演算能力も大幅に高まるのだ。』

こちらの記事の中には英語ですが、コインの表裏を例にした説明動画があります。これは量子力学の奇妙な原理の一つ、「重ね合わせ」を説明するものです。

偉そうに説明できるような知識は持っていないのですが、過去ブログの“量子論1”に戻って少しご説明します。なお、ここでご紹介している内容および画像は、「13歳からの量子論のきほん」という本からです。

量子論が生まれた理由

『あらゆる物質は、「原子」からできていることがわかっています。19世紀末ごろになって、原子がかかわる現象を詳しく調べてみると、ミクロな世界は私たちが日常生活で目にする世界とはまったくちがうことがわかってきました。ミクロの世界は私たちが日常生活で目にする世界とはまったくちがうことがわかってきました。ミクロな物質は、私たちの常識では説明できない、摩訶不思議なふるまいをするのです。

そこで、新しい理論が必要になりました。それが「量子論」です。量子論とは「非常に小さなミクロな世界で、物質を構成する粒子や光などがどのようにふるまうかを解き明かす理論」といえます。』

量子論と日常生活の関係

『マクロな世界の物体の運動に量子論を適用すると、計算量が膨大になってしまいます。そこで実用上は、計算が楽な古典論が使われます。マクロな世界では、量子論による計算結果と古典論による計算結果が、ほとんど同じになるのです。なおマクロな世界にも、量子論を使わないと説明できない現象はあります。「金属(導体)」「絶縁体」「半導体」の性質のちがいや、「超流動」や「超電導」といった現象です。』

量子論の二つの重要事項

●波と粒子の二面性:“電子や光は、波と粒子の性質をあわせもつ”

●状態の共存(重ね合わせ):“一つの電子は、箱の左右に同時に存在できる”

Newsweekの記事にあったコインの動画は、上記の「状態の共存(重ね合わせ)」を説明したものということになります。

以前、ネットで見つけた例えでは次のようなものもありました。

「道を歩いていたら、道が3つに分かれた。1番早く目的地に着ける道を選びたいが、選べるのは1つしかない。従って、結果的に1番早い道を選べる確率は1/3(約33.33%)である。

一方、量子の世界では、【重ね合わせ】という奇妙な原理のお陰で3つの道を同時に歩いて行ける。よって、1番早い道を選べる確率は100%である」。

「Google 恐るべし!!」

そこで、Google がどんな会社か知りたいと思い、“How Google Works(私たちの働き方とマネジメント)”という本を購入したという経緯です。

ブログは目次に続き、共同創業者であるラリー・ペイジの言葉と本書の骨子的なメッセージをお伝えし、続いてGoogle のDNAではないかと思われる“スマート・クリエイティブ”と“ラーニング・アニマル”、そして、イノベーションという章の中のテーマから、“自らとりまく環境を理解する”と“良い失敗をする”をご紹介します。

目次は大見出しのみご紹介させて頂きます。

序文

はじめに

文化 自分たちのスローガンを信じる

戦略 あなたの計画は間違っている

人材 採用は一番大切な仕事

意思決定 「コンセンサス」の本当の意味

コミュニケーション とびきり高性能のルータになれ

イノベーション 原始スープを生み出せ

おわりに

序文

『グーグルは「自律的思考」をあらゆる活動の基礎にしていた。それはぼくらの誇るすばらしい成功、そしてときにはとんでもない失敗の原動力となった。』 グーグルCEO兼共同創業者 ラリー・ペイジ

はじめに

楽しいプロジェクト

『本書は成功・成長している企業やベンチャーの発達過程をたどるような構成になっている。この発達過程は、雪玉が坂道を転がっていくうちに勢いがつき、どんどん大きくなっていくような、永続的な好環境に発展できるものだ。一連のステップは、スマート・クリエイティブを惹きつけ、意欲を高めるために企業が実践可能なものだ。その一つひとつが企業を次のステップへと押し上げていく。各ステップは相互に依存し、お互いの上に成り立っている。またどのステップも決して終わることのない、ダイナミックなものだ。

まずは最高のスマート・クリエイティブを惹きつける方法から始める。その出発点は企業文化だ。なぜなら企業文化とビジネスの成功は切り離して考えることはできないからだ。自分たちのモットーを信じられなければ、大成功はとうてい望めない。次に取り上げるのが戦略だ。スマート・クリエイティブは強固な戦略の土台に根差したアイデアに何より魅力を感じる。事業計画を支える戦略の柱こそが、事業計画そのものよりもはるかに重要だとよくわかっている。その次が採用だ。これはリーダーの最も大切な仕事である。最高の人材を十分に集めることができれば、知性と知性が混じり合い、クリエイティビティと成功が生まれるのは確実だ。』

スマート・クリエイティブ

・こんにちの労働環境は、20世紀とは本質的に異なる。実験のコストは安くなり、失敗のコストもかつてよりは大幅に低くなった。そのうえ、データもコンピューティングのリソースも豊富になり、自由に使えるようになった。部署を越え、大陸や海を越えての協業も簡単にできる。こうした要素が組み合わさった結果、突如としてひとりのプレイヤー、マネジャー、経営者にいたるまで、働く人間がとほうもないインパクトを生み出せるようになった。

・IBM、ゼネラル・エレクトリック(GE)、ゼネラル・モーターズ(GM)、ジョンソン・エンド・ジョンソンなどの優れた企業は、有望な人材に2~3年ずつさまざまな部署を経験させる経営幹部養成トラックを設けている。だがこの仕組みは専門能力ではなく、経営能力を高めることを目的としている。この結果、従来型企業で働く知識労働者のほとんどは、専門分野に秀でているか、幅広い経営能力を備えているか、どちらかの能力に片寄っているのが普通である。

・従来型の知識労働者と、グーグルのエンジニアを比べてみると、まったく違うタイプであることがわかる。グーグルの社員は会社の情報やコンピューティング能力に自由にアクセスできる。リスクテイクをいとわず、またそうしたリスクをともなう取り組みが失敗したとしても処罰や不利益を受けることはない。職務や組織構造に束縛されることなく、むしろ自分のアイデアを実行に移すよう奨励されている。納得できないことがあれば、黙ってはいない。退屈しやすく、しょっちゅう職務を変える。多才で、専門性とビジネススキルと創造性を併せ持っている。私たちが「スマート・クリエイティブ」と呼ぶ新種で、インターネットの世紀での成功のカギを握る存在である。

・こんにち成功している企業の際立った特色は、最高のプロダクトを生み出しつづける能力である。それを手に入れる道は、「スマート・クリエイティブ」を惹きつけ、彼らがとてつもない偉業を成し遂げられるような環境をつくりだすことである。

・スマート・クリエイティブは、自分の“商売道具”を使いこなすための高度な専門知識を持っており、経験値も高い。

・スマート・クリエイティブは、実行力に優れ、単にコンセプトを考えるだけでなく、プロトタイプをつくる人間である。

・スマート・クリエイティブは、分析力も優れている。データを扱うのが得意で、それを意思決定に生かすことができる。同時にデータの弱点もわかっており、いつまでも分析を続けようとはしない。データに判断させるのは構わないが、それに振り回されるのはやめようと考える。

・スマート・クリエイティブは、ビジネス感覚も優れている。専門知識をプロダクトの優位性や事業の成功と結びつけて考えることができ、そのすべてが重要であることをわかっている。競争心も旺盛である。成功にはイノベーションが不可欠だが、猛烈な努力も欠かせない。

・スマート・クリエイティブは、頂点を目指す意欲にあふれ、ユーザのこともよくわかっている。どんな業界に身を置いているかにかかわらず、スマート・クリエイティブはプロダクトを誰よりもユーザ目線、あるいは消費者の視点から見ることができる。自らが「パワー・ユーザ」で興味の対象に取りつかれたようにのめり込む。

・スマート・クリエイティブからは、斬新なアイデアがほとばしり出る。他の人とはまったく違う視点があり、ときには本来の自分とも違う視点に立つ。必要に応じて、カメレオン的に視点を使い分けることができる。

・スマート・クリエイティブは、好奇心旺盛である。常に疑問を抱き、決して現状に満足せず、常に問題を見つけて解決しようとし、それができるのは自分しかいないと確信している。傲慢に見えることもあるかもしれない。